Das Ende der Umfrage: Warum Enterprise traditionelle Forschung durch KI-Monitoring ersetzt

Letzte Aktualisierung: 15. October 2025

Eine stille Revolution transformiert, wie große Unternehmen ihre Märkte verstehen. Jahrzehntelang bildeten traditionelle Umfragen und Fokusgruppen das Fundament der strategischen Planung. Heute bröckelt dieses Fundament — und die größten Unternehmen der Welt wetteifern darum, es zu ersetzen.

Inhaltsverzeichnis

- Die Krise der traditionellen Forschung

- Umfragemüdigkeit: Der Datenqualitätskollaps

- Das Geschwindigkeitsproblem: Wenn Erkenntnisse zu spät kommen

- Der Aufstieg des KI-Modell-Pollings

- Praxisbeispiel: Das Automobilbeispiel

- Warum die Enterprise-Nachfrage explodiert

- FAQ

Die Krise der traditionellen Forschung

Betrachten Sie ein Szenario, das sich in Vorstandssitzungen der Fortune 500 abspielt: Ein großer Automobilhersteller bereitet die Markteinführung eines neuen Crossover-Modells vor. Im traditionellen Paradigma gleicht die Einholung von Marktfeedback dem Steuern eines Ozeanriesen — langsam, teuer und frustrierend ungenau.

Der Forschungsprozess könnte so aussehen:

- Woche 1-2: Fragebogen entwerfen, mit Agentur verhandeln

- Woche 3-4: Repräsentative Stichprobe rekrutieren

- Woche 5-8: Feldforschung, Antworten sammeln

- Woche 9-10: Datenbereinigung, ungültige Antworten aussortieren

- Woche 11-12: Analyse und Berichtsübergabe

Bis die Erkenntnisse eintreffen, hat sich der Markt bereits verändert. Wettbewerberkampagnen wurden gestartet. Die Verbraucherstimmung hat sich weiterentwickelt. Die sorgfältig gesammelten Daten beschreiben eine Welt, die nicht mehr existiert.

Das ist kein Gedankenexperiment — es ist der Alltag von Enterprise-Forschungsteams.

Umfragemüdigkeit: Der Datenqualitätskollaps

Die Umfragebranche steht vor dem, was Forscher „Aufmerksamkeitsinflation" nennen. Jede Markeninteraktion — Kaffee kaufen, Support anrufen, eine Website besuchen — endet mit der Bitte, „Ihr Erlebnis zu bewerten." Dieses unerbittliche Bombardement hat Umfragemüdigkeit ausgelöst, ein Phänomen, bei dem sich die Antwortqualität verschlechtert, je mehr Anfragen gestellt werden.

Forschung aus Langzeitstudien zeigt eine klare Korrelation: Je häufiger Befragte kontaktiert werden, desto geringer Qualität und Quantität ihrer Antworten. Menschen antworten mechanisch, wählen zufällige Optionen, um Popup-Fenster zu schließen, oder ignorieren Anfragen komplett.

Die Zustellbarkeitskrise

Das Problem verschärft sich durch technische Barrieren. 2025 filtern E-Mail-Plattformen wie Gmail und Outlook Umfrageeinladungen aggressiv. Zustellraten für Forschungsplattformen sind um 19-27% gesunken — Unternehmen verlieren physisch den Zugang zu ihrem Publikum, unabhängig vom Budget.

Selektionsverzerrung und Datenbetrug

Wenn Antworten eintreffen, leiden sie unter kritischen Verzerrungen:

- Selektionsverzerrung: Nur Markenbefürworter und verärgerte Kritiker antworten; die „schweigende Mehrheit" verschwindet

- Schlechte Daten: Bots und unehrliche Panelteilnehmer generieren Zufallsantworten für Anreize

- Qualitätsverfall: Analysten verwerfen bis zu 20% der Datensätze wegen offensichtlichem Betrug

Das Ergebnis: teure Forschung, die unzuverlässige Schlussfolgerungen liefert.

Das Geschwindigkeitsproblem: Wenn Erkenntnisse zu spät kommen

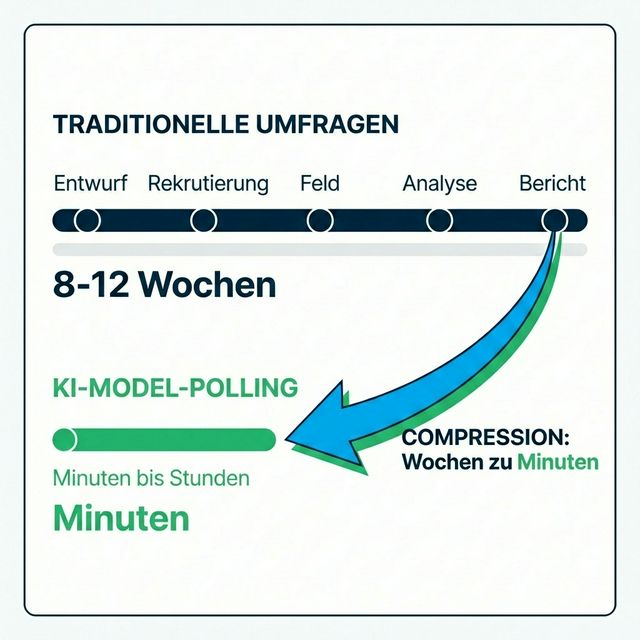

Zurück zu unserem Automobilbeispiel. In der heutigen dynamischen Wirtschaft stellt ein 8-12-wöchiger Forschungszyklus eine Ewigkeit dar. Trends können innerhalb dieses Fensters entstehen, ihren Höhepunkt erreichen und wieder verschwinden. Entscheidungen auf Basis veralteter Daten sind nicht nur ineffektiv — sie sind gefährlich.

Wenn ein Wettbewerber Echtzeit-Social-Signale überwacht und innerhalb von 24 Stunden auf Nutzerreklamationen reagiert, verliert das Unternehmen, das auf Quartalsberichte wartet, unweigerlich Marktanteile.

Die Daten treffen ein, wie Praktiker trocken bemerken, „verspätet, verzerrt und nicht-objektiv."

Der Aufstieg des KI-Modell-Pollings

Die Antwort auf diese Krise kommt aus einer unerwarteten Richtung: die Nutzung von Large Language Models als Proxy-Befragte. Dieser Ansatz — oft Model Polling oder „synthetische Forschung" genannt — basiert auf einer revolutionären Prämisse: Moderne LLMs, trainiert auf dem gesamten öffentlichen Internet, enthalten ein komprimiertes Modell der menschlichen Gesellschaft selbst.

Wie Model Polling funktioniert

Statt 500 Personen über spezifische Demografien zu rekrutieren und für das Ausfüllen von Umfragen zu bezahlen, erstellen Enterprise-Unternehmen nun synthetische Personas. Mit spezialisierten System-Prompts kann ein einzelnes Modell (wie GPT-4 oder Claude) diverse demografische Profile simulieren:

- „Sie sind eine 35-jährige Vorstadtmutter, die sich um Sicherheit sorgt"

- „Sie sind ein 20-jähriger Technikstudent auf der Suche nach budgetfreundlichem Stil"

Die Vorteile gegenüber traditioneller Forschung sind fundamental:

| Faktor | Traditionelle Umfragen | KI-Modell-Polling |

|---|---|---|

| Geschwindigkeit | 8-12 Wochen | Minuten bis Stunden |

| Kosten | Vollbudget | 10-25% des Traditionellen |

| Skalierung | Hunderte Befragte | Millionen Simulationen |

| Verzerrung | Beobachtereffekt, sozialer Druck | Keine |

| Sensible Themen | Zurückhaltung, Unehrlichkeit | Volle Transparenz |

Forschung zeigt, dass 87% der Teams, die synthetische Daten nutzen, Zufriedenheit mit den Ergebnissen ausdrücken und hohe Korrelation mit tatsächlichem Marktverhalten feststellen.

Praxisbeispiel: Das Automobilbeispiel

Kehren wir zu unserem Automobilhersteller zurück. Im neuen Paradigma wartet das Produktteam nicht mehr Monate, um die Kundenreaktion auf eine Feature-Entscheidung zu verstehen.

Traditioneller Ansatz: „Sollen wir eine beheizte Lenkradheizung serienmäßig einbauen?"

- 10-Wochen-Studie, 200.000$ Budget, verzögerte Entscheidung

KI-Monitoring-Ansatz: Mehrere KI-Modelle abfragen, die mit Echtzeit-Datenströmen von Reddit, Autoforen und Social Media verbunden sind

- Ergebnisse in Stunden, kontinuierliches Monitoring, sofortige Iteration

Die Modelle greifen nicht auf zwei Jahre alte Trainingsdaten zurück. Durch Architekturen wie RAG (Retrieval-Augmented Generation) verbinden sie sich mit Vektordatenbanken, die mit Beiträgen der letzten 24 Stunden gefüllt sind. Die KI synthetisiert die Marktreaktion in Echtzeit.

Deshalb ist das Enterprise-Interesse an KI-Monitoring explodiert. Bei AICarma haben wir beobachtet, dass Enterprise-Anfragen mittlerweile das SMB-Interesse in unserer organischen Akquise übertreffen — und die Herausforderungen, die sie mitbringen, sind weitaus anspruchsvoller und erfordern tiefe Expertise in Multi-Modell-Architekturen und Entity-Monitoring.

Warum die Enterprise-Nachfrage explodiert

Die Verschiebung von Umfragen zu KI-Monitoring wird nicht von Neugier angetrieben — sondern von wettbewerblicher Notwendigkeit:

- Geschwindigkeitsanforderungen: Märkte bewegen sich in Tagen, nicht in Quartalen

- Kostendruck: Traditionelle Forschungsbudgets stehen unter Beobachtung

- Qualitätsbedenken: Zuverlässigkeit von Umfragedaten sinkt weiter

- KI-Integration: Unternehmen betten KI in alle Geschäftsprozesse ein

- Reputationsmanagement: Notwendigkeit, KI-generierte Markenwahrnehmungen in Echtzeit zu überwachen

Für Unternehmen, die an das Management der Sichtbarkeit über mehrere KI-Modelle gewöhnt sind, fühlt sich der Übergang von passiver Forschung zu aktivem Monitoring natürlich an. Für jene, die sich noch auf Quartalsberichte verlassen, fühlt es sich an, als würde sich der Boden unter ihren Füßen bewegen.

FAQ

Sind KI-generierte Erkenntnisse so zuverlässig wie menschliche Umfragen?

Für viele Anwendungsfälle ja — und oft sogar zuverlässiger. KI eliminiert Beobachtereffekte, soziale Erwünschtheit und Umfragemüdigkeit. Forschung zeigt 87% Zufriedenheitsraten bei Enterprise-Teams, die synthetische Befragte nutzen. Allerdings funktioniert KI am besten in Kombination mit menschlicher Validierung für emotional nuancierte oder kulturell sensible Themen.

Wie schnell können Unternehmen KI-Monitoring implementieren?

Spezialisierte Plattformen ermöglichen Deployment in Wochen statt Monaten. Die Herausforderung ist nicht die Geschwindigkeit — es ist die Wahl des richtigen Ansatzes und die korrekte Integration in bestehende Forschungs-Workflows.

Bedeutet das, dass traditionelle Forschung obsolet ist?

Nicht vollständig. Qualitative Tiefeninterviews, ethnografische Forschung und bestimmte Langzeitstudien behalten ihren Wert. Aber für schnellzyklische taktische Erkenntnisse wird KI-Monitoring rapide zum Enterprise-Standard.

Welche Infrastruktur wird benötigt?

Enterprise-KI-Monitoring erfordert richtige technische Grundlagen — Zugang zu mehreren LLM-Anbietern, Echtzeit-Datenaufnahme-Fähigkeiten und anspruchsvolle Orchestrierungsschichten. Diese Infrastruktur intern aufzubauen ist möglich, aber zunehmend komplex.

Der Übergang von umfragebasierter Forschung zu KI-gestütztem Monitoring stellt eine der bedeutendsten Verschiebungen in der Corporate Intelligence seit dem Internet selbst dar. Unternehmen, die diese Fähigkeit meistern, gewinnen Echtzeit-Marktvisibilität. Jene, die es nicht tun, riskieren Entscheidungen auf Basis von Daten, die die Welt von gestern beschreiben — während Wettbewerber morgen sehen.