Survivre au Changement : Un Playbook Stratégique pour Gérer la Volatilité de la Recherche IA

Dernière mise à jour : 30 August 2025

Nous avons tous vu ça arriver : lundi, votre marque est la recommandation numéro un dans ChatGPT pour votre catégorie. Mardi, une mise à jour du modèle est déployée, la température change, et vous disparaissez. Mercredi, vous êtes de retour — mais en troisième position. Vendredi, vous avez encore disparu.

Comme nous l'avons documenté dans notre Guide sur la Volatilité de la Recherche IA, cette instabilité n'est pas un bug. C'est la nature fondamentale des systèmes probabilistes. Les recommandations IA sont générées par échantillonnage à partir de distributions de probabilité — pas récupérées depuis un index fixe.

Comprendre pourquoi ça arrive était la première étape. Cet article est la deuxième : construire un playbook stratégique pour survivre, exploiter et finalement prospérer dans un environnement de recherche IA volatile.

Table des Matières

- Le Coût de la Panique Face à la Volatilité

- Stratégie 1 : L'Approche Portefeuille

- Stratégie 2 : Le Fossé de Données Propriétaires

- Stratégie 3 : Le Bouclier de Corroboration

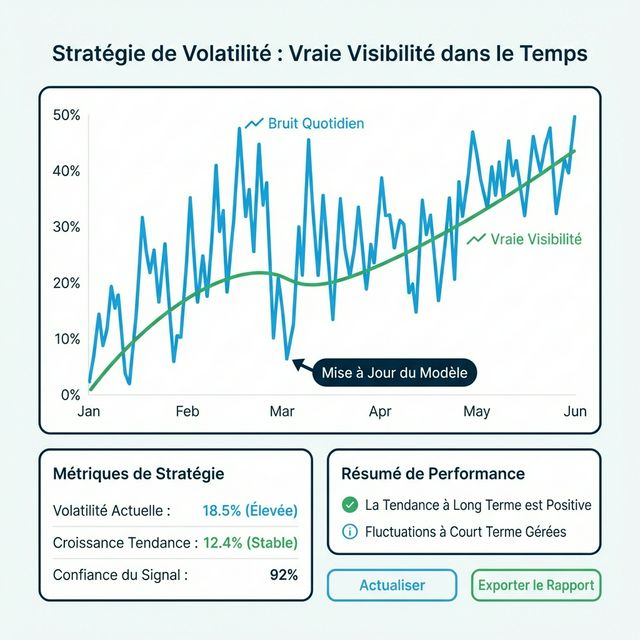

- Stratégie 4 : Le Framework de Reporting par Tendances

- Stratégie 5 : Exploiter les Fenêtres de Volatilité

- La Science de l'Instabilité IA

- Construire une Marque Anti-Fragile

- Playbooks de Volatilité par Secteur

- FAQ

Le Coût de la Panique Face à la Volatilité

Avant de discuter des solutions, quantifions le problème. La volatilité elle-même ne détruit pas les marques. Les réactions de panique à la volatilité les détruisent.

Nous avons observé des équipes commettre ces erreurs coûteuses :

| Réaction de Panique | Coût Réel | Meilleure Réponse |

|---|---|---|

| « On a chuté dans ChatGPT ! Tout réécrire ! » | 15-30K€ en production de contenu gaspillés sur du bruit | Attendez 7 jours. Vérifiez si c'est une tendance ou un pic. |

| « Coupez le monitoring IA — les chiffres font trop peur. » | Perte d'alerte précoce sur les baisses réelles | Passez des instantanés quotidiens aux moyennes mobiles hebdomadaires |

| « Notre concurrent nous a dépassés — copions leur stratégie ! » | Copier des tactiques sans comprendre le contexte | Analyse concurrentielle pour comprendre pourquoi ils ont progressé |

| « L'IA est trop imprévisible. Concentrons-nous sur Google. » | Abandonner un canal en croissance de 300 %/an | Accepter la volatilité comme le prix de l'avantage du premier arrivé |

Les recherches de Kahneman en économie comportementale (Prix Nobel, 2002) démontrent que les humains sont aversifs aux pertes : les pertes sont ressenties environ deux fois plus douloureusement que les gains équivalents ne sont plaisants. Cela signifie qu'une baisse de visibilité de 10 points semble catastrophique même si la semaine précédente a apporté un gain de 10 points. L'antidote est une stratégie systématique basée sur les données — pas une réaction émotionnelle.

Stratégie 1 : L'Approche Portefeuille

En finance, on ne mise pas tout sur une seule action. En GEO, miser tout sur un seul modèle est tout aussi dangereux.

Diversification des Modèles

Les différents modèles IA ont des architectures, données d'entraînement et mécanismes de récupération fondamentalement différents :

| Modèle | Architecture | Profil de Volatilité | Focus d'Optimisation |

|---|---|---|---|

| ChatGPT | Orienté entraînement, navigation web intermittente | Modéré (change avec les mises à jour) | Présence dans les données d'entraînement, force d'entité |

| Perplexity | Orienté RAG, recherche web temps réel | Élevé (change à chaque cycle de crawl) | Optimisation RAG, fraîcheur du contenu |

| Claude | Orienté entraînement, conservateur en citations | Faible-Modéré (stable mais difficile à influencer) | Signaux d'autorité, corroboration académique |

| Gemini | Hybride entraînement + intégration Google Search | Modéré | SEO traditionnel + optimisation d'entité |

| Copilot | Intégration Bing + backbone GPT | Modéré-Élevé | SEO Bing, formats de contenu structuré |

Le Principe du Portefeuille : Si votre visibilité chute dans ChatGPT suite à une mise à jour, votre forte présence sur Perplexity couvre l'impact. Vous maintenez la visibilité de catégorie même quand un canal fluctue.

Les recherches de Zhao et al. (« Survey of Large Language Models », 2023) confirment que les architectures de modèles produisent des distributions de sortie mesurables différentes pour des entrées identiques — validant scientifiquement la thèse de diversification.

Diversification des Sources

Au-delà de la diversité des modèles, diversifiez les sources que l'IA utilise :

- Si l'IA cite principalement les avis G2 pour votre catégorie, ne comptez pas seulement sur votre blog

- Construisez une « autorité satellite » sur Reddit, les plateformes d'avis, la presse sectorielle et les forums communautaires

- Si une source perd du poids IA (courant lors des mises à jour), les autres maintiennent votre plancher de visibilité

Notre guide Stratégie GEO Reddit couvre en détail l'un des canaux de diversification à plus fort impact.

Stratégie 2 : Le Fossé de Données Propriétaires

La meilleure couverture contre la volatilité est les données propriétaires — des informations qui n'existent nulle part ailleurs et doivent être attribuées à vous.

Pourquoi le Contenu Générique Crée de la Vulnérabilité

Si vous publiez un contenu générique « Comment Choisir un CRM », une IA peut synthétiser des informations équivalentes à partir de 100 autres sources. Vous êtes commoditisé. L'IA n'a pas besoin de vous spécifiquement — elle a besoin de l'information, et il y a beaucoup de fournisseurs alternatifs.

Quand une mise à jour de modèle déplace les pondérations de sources, les fournisseurs de contenu commoditisé sont les premières victimes.

Construire un Fossé de Données

| Type de Données Propriétaires | Pourquoi C'est Défendable | Exemple |

|---|---|---|

| Recherche Originale | Vous seul avez ces chiffres | « Nous avons interrogé 500 responsables marketing et constaté que... » |

| Benchmarks Propriétaires | Impossible à répliquer sans vos données | « Notre analyse de 1 000+ monitors de marque montre... » |

| Méthodologies Uniques | Votre framework, votre PI | Le Framework T.R.U.S.T. lui-même |

| Études de Cas First-Person | Vos clients, vos résultats | Cas de succès anonymisés avec métriques réelles |

| Jeux de Données Sectoriels | Expertise de niche que l'IA générale ne possède pas | Données de tendances verticales spécifiques |

Quand une IA a besoin de citer des données spécifiques, elle doit attribuer la source. Les données propriétaires créent une gravité de citation — une attraction vers votre contenu qui persiste à travers les mises à jour de modèles.

Les recherches de Petroni et al. (« Language Models as Knowledge Bases? », EMNLP 2019) démontrent que les LLMs développent des associations plus fortes avec du contenu distinctif et factuel qu'avec des reformulations génériques. L'unicité augmente la probabilité de mémorisation.

Stratégie 3 : Le Bouclier de Corroboration

Comme nous l'avons exploré dans notre guide SEO des Données d'Entraînement, les modèles IA assignent la confiance basée sur la corroboration — trouver le même fait à travers plusieurs sources indépendantes.

La Courbe de Confiance de Corroboration

| Nombre de Sources Indépendantes | Niveau de Confiance IA |

|---|---|

| 1 (votre site web uniquement) | Faible — le modèle peut nuancer avec « certaines sources suggèrent... » |

| 2-3 (site + 1-2 externes) | Modéré — le modèle cite avec une confiance raisonnable |

| 5+ (site + avis + presse + Reddit + Wikipedia) | Élevé — le modèle énonce comme fait établi |

| 10+ (corroboration saturée) | Très Élevé — même les mises à jour de modèle vous délogent rarement |

La courbe de confiance n'est pas linéaire — elle suit un schéma logarithmique. Le saut de 1 à 3 sources produit plus de gain de stabilité que le saut de 7 à 10. Concentrez vos efforts initiaux sur la corroboration dans 3-5 sources à fort poids avant de vous disperser.

Ce principe a été formalisé par Dong et al. dans leur recherche Knowledge Vault (« Knowledge Vault: A Web-Scale Approach to Probabilistic Knowledge Fusion », KDD 2014), qui a démontré que la fusion multi-sources améliore dramatiquement la confiance dans les connaissances des systèmes automatisés.

Actions Pratiques de Corroboration

- Assurez-vous que vos affirmations clés apparaissent sur votre site, Wikipedia (si éligible), au moins 2 plateformes d'avis, et 1+ publication sectorielle

- Construisez votre présence d'Entité sur Wikidata, Crunchbase, la Page Entreprise LinkedIn et le Knowledge Panel Google

- Gagnez des mentions authentiques dans les discussions Reddit — pas des posts marketing, mais des contributions communautaires utiles

Stratégie 4 : Le Framework de Reporting par Tendances

Peut-être la stratégie la plus immédiatement actionnable : changez comment vous rapportez la performance IA aux parties prenantes.

Pourquoi le Reporting Traditionnel Échoue

Quand votre directeur marketing demande « Quel est notre classement dans ChatGPT ? », la réponse honnête est complexe. Mais la complexité ne passe pas en réunion de direction.

Le reporting SEO traditionnel fonctionne parce que le système sous-jacent est relativement stable :

- « On est classé #3 pour [mot-clé] » — significatif, vérifiable, stable

- « Notre classement s'est amélioré de #7 à #4 » — direction claire

Le reporting IA nécessite un changement de paradigme parce que le système sous-jacent est probabiliste :

- « Notre Taux de Visibilité cette semaine est de 52 % » — instantané, incomplet

- « Notre Visibilité moyenne sur 4 semaines est de 50 %, en hausse par rapport à 42 % le trimestre dernier » — tendance, significatif

Le Dashboard Exécutif Recommandé

| Métrique | Cette Période | Précédente | MM 4 Semaines | Tendance |

|---|---|---|---|---|

| Taux de Visibilité IA | 52 % | 48 % | 50 % | ↗️ En amélioration |

| Score de Sentiment | 8,2/10 | 8,0/10 | 8,1/10 | → Stable |

| Couverture Multi-Modèles | 4/5 modèles | 3/5 | 3,5/5 | ↗️ En amélioration |

| Visibilité Concurrent A | 45 % | 47 % | 46 % | ↘️ En déclin |

| Bande de Volatilité | ±8 % | ±12 % | ±10 % | ↗️ En stabilisation |

Notez l'innovation clé : la Bande de Volatilité (±%) est elle-même une métrique. Une bande de volatilité qui se rétrécit signifie que votre position se solidifie — un meilleur résultat qu'un chiffre de visibilité plus élevé avec des oscillations plus larges.

L'Analogie « Bulletin Météo »

« Votre visibilité IA est comme un bulletin météo. Si on dit qu'il y a 70 % de chance de pluie et qu'il ne pleut pas, on s'est trompé ? Non — on a eu raison 30 % du temps, ce qui était toujours possible. De même, si notre Taux de Visibilité IA est de 50 %, on s'attend à apparaître dans environ la moitié des requêtes pertinentes. Certains jours seront à 40 %, d'autres à 60 %. La moyenne sur 4 semaines nous dit le vrai climat. »

Ce cadrage, emprunté au Superforecasting de Tetlock (Crown, 2015), aide les dirigeants à développer le bon modèle mental pour les métriques probabilistes.

Stratégie 5 : Exploiter les Fenêtres de Volatilité

Voici l'insight contre-intuitif : la volatilité n'est pas seulement une menace. C'est une opportunité.

La Théorie de la « Fenêtre Ouverte »

Si les recommandations IA étaient parfaitement stables — comme l'ancienne Page Une de Google — les incumbents seraient définitivement verrouillés. Les nouveaux entrants n'auraient aucun chemin vers la visibilité.

Mais la volatilité crée des fenêtres d'opportunité :

| Événement de Volatilité | Ce que Ça Signifie | Votre Mouvement |

|---|---|---|

| Mise à jour de modèle qui redistribue les classements | Les positions hautes sont temporairement « déverrouillées » | Déployez votre contenu le plus fort immédiatement |

| La visibilité d'un concurrent chute | L'IA les « oublie » temporairement | Augmentez votre signal sur leurs requêtes affaiblies |

| Nouvelle catégorie de requête émerge | Aucun incumbent n'a établi d'autorité | Créez du contenu autoritaire rapidement pour l'avantage du premier arrivé |

| Rotation des sources RAG | L'IA regarde des sources différentes | Assurez-vous d'être présent sur plus de sources |

Timer Vos Mouvements

Les mises à jour majeures de modèles sont souvent annoncées (ou détectées par la communauté en quelques heures). Quand une mise à jour sort :

- Surveillez immédiatement — Les utilisateurs AICarma reçoivent des alertes automatisées quand leurs métriques changent significativement

- Évaluez sous 48 heures — Le changement est-il bénéfique (opportunité) ou préjudiciable (menace) ?

- Agissez sous 1 semaine — Déployez du nouveau contenu, mettez à jour les pages existantes, renforcez les piliers plus faibles

- Mesurez sous 2 semaines — La réponse a-t-elle stabilisé votre position ?

Cette cadence est plus rapide que les réactions trimestrielles du SEO traditionnel — et elle doit l'être, parce que l'environnement change plus vite.

La Science de l'Instabilité IA

Pour les curieux techniques, voici pourquoi les résultats IA sont fondamentalement volatils.

Température et Échantillonnage par Noyau

Les LLMs génèrent du texte en prédisant le prochain token le plus probable. Le paramètre de température contrôle à quel point cette prédiction est « créative » :

- Température 0,0 : Choisit toujours le token le plus probable (déterministe, variété minimale)

- Température 0,7 : Échantillonne à partir d'une gamme plus large de tokens probables (équilibré)

- Température 1,0+ : Échantillonne largement, y compris des tokens moins probables (créatif, haute variance)

Comme documenté par Holtzman et al. (« The Curious Case of Neural Text Degeneration », ICLR 2020), même des réglages de température modérés produisent une variation significative des sorties sur des exécutions répétées avec des entrées identiques.

Vous ne pouvez pas contrôler la température — seul le fournisseur IA le peut. Mais vous pouvez construire une masse de probabilité si forte autour de votre marque que même l'échantillonnage à haute température vous sélectionne fréquemment.

Fréquence des Mises à Jour de Modèle

Chen et al. (« How is ChatGPT's Behavior Changing Over Time? », 2023) ont suivi le comportement de GPT-3.5 et GPT-4 sur plusieurs mois et trouvé une dérive comportementale significative — même entre des versions de modèle ostensiblement identiques. Cette « dérive silencieuse » signifie que votre visibilité peut changer sans aucune mise à jour annoncée.

L'implication : le monitoring continu n'est pas optionnel. C'est le seul moyen de détecter les changements silencieux avant qu'ils ne se composent.

Construire une Marque Anti-Fragile

L'objectif ultime n'est pas seulement de survivre à la volatilité — c'est de devenir anti-fragile (Taleb, Antifragile, Random House, 2012) : une marque qui bénéficie réellement de l'instabilité.

Les marques anti-fragiles partagent ces traits :

- Présence d'Entité Profonde : Leur profil Knowledge Graph est si fort que même les mises à jour majeures de modèles préservent leurs associations

- Corroboration Multi-Sources : Elles sont citées sur 10+ sources indépendantes, rendant la disruption d'une seule source sans conséquence

- Données Propriétaires : Elles possèdent des informations uniques que l'IA doit leur attribuer

- Couverture de Modèles Diversifiée : Elles apparaissent sur tous les modèles majeurs, pas un seul

- Capacité de Réponse Rapide : Elles détectent les changements sous 48 heures et déploient des réponses sous une semaine (Volant d'Inertie GEO)

Playbooks de Volatilité par Secteur

Différents secteurs font face à différents profils de volatilité. Adaptez votre stratégie en conséquence :

Faible Volatilité : Santé & Finance

Pourquoi : L'IA applique des filtres de sécurité YMYL stricts. Les recommandations sont conservatrices et changent lentement. Stratégie : Investissez massivement dans le pilier Confiance. Une fois établi, les positions sont durables. Mais l'entrée est intentionnellement difficile.

Volatilité Moyenne : SaaS & B2B

Pourquoi : Plusieurs options comparables, avec documentation et avis de qualité. Stratégie : Différenciez-vous via des benchmarks propriétaires. Le Playbook GEO SaaS couvre cela en détail.

Haute Volatilité : E-commerce & Local

Pourquoi : Les prix, disponibilités et avis changent constamment. Stratégie : La vitesse et la fraîcheur comptent davantage. Maintenez des avis récents et des données structurées en temps réel.

FAQ

Dois-je vérifier ma visibilité IA quotidiennement ?

Non. Les vérifications quotidiennes créent de l'anxiété sans information actionnable. Les fluctuations quotidiennes sont principalement du bruit — un effet de l'échantillonnage de température et de la variance de récupération. Vérifiez les moyennes mobiles hebdomadaires. Exception : si votre système d'alerte signale une baisse dépassant 30 %, enquêtez immédiatement.

Mon concurrent a vu sa visibilité augmenter après une mise à jour de modèle. Dois-je paniquer ?

Pas immédiatement. Les mises à jour de modèle créent souvent des redistributions temporaires. Donnez-vous 2 semaines avant de conclure que le changement est permanent. Pendant cette fenêtre, analysez pourquoi ils ont progressé — ont-ils publié du nouveau contenu ? Ont-ils gagné une nouvelle citation autoritaire ? Puis répondez stratégiquement, pas réactivement.

Quel niveau de volatilité est « normal » ?

Pour les requêtes de catégorie dans les marchés compétitifs, attendez-vous à une variation de ±15-20 % d'une semaine à l'autre comme référence. Si votre volatilité est constamment sous ±10 %, votre position est solide. Si elle est au-dessus de ±25 %, votre position est fragile et nécessite un travail de corroboration.

Puis-je utiliser les données de volatilité pour prédire les mises à jour de modèle ?

Parfois. Quand la volatilité augmente simultanément pour plusieurs marques dans la même catégorie — sans changement de contenu évident de la part d'aucune d'entre elles — cela indique souvent une mise à jour de modèle ou un changement du système de récupération. Nous avons observé ce schéma de façon fiable à travers les données de monitoring d'AICarma.

Quelle est la chose la plus importante pour la résilience à la volatilité ?

La force d'entité. Une entité de marque forte et bien corroborée survit aux mises à jour de modèle mieux que tout le reste. Les entités sont l'unité de connaissance la plus persistante dans les LLMs — elles sont intégrées dans les poids, corroborées à travers les sources, et résistantes au bruit de récupération.