Das T.R.U.S.T. Framework: Ein 5-Säulen-Audit für KI-Such-Dominanz

Letzte Aktualisierung: 25. August 2025

Wenn die KI-Sichtbarkeit sinkt, ist der erste Instinkt Panik. Der zweite ist Raten.

„Vielleicht brauchen wir mehr Content." „Vielleicht ist es ein Modell-Update." „Vielleicht sollten wir Prompt-Injection versuchen." (Bitte nicht.)

Raten passiert, wenn Sie kein Diagnose-Framework haben. Und in einem Feld so komplex wie Generative Engine Optimization, wo dutzende Variablen über mehrere KI-Modelle gleichzeitig interagieren, ist Raten teuer.

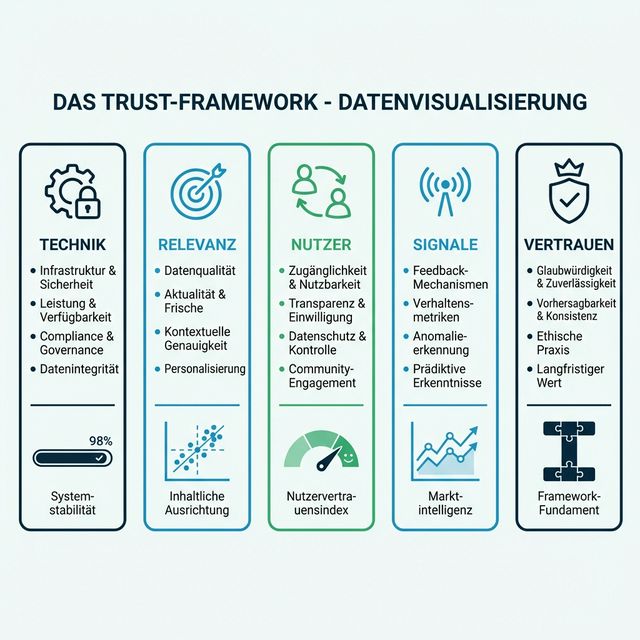

Deshalb haben wir das T.R.U.S.T. Framework entwickelt — ein strukturiertes Fünf-Säulen-Audit-System zur Diagnose und Verbesserung der Sichtbarkeit Ihrer Marke in der KI-Suche.

Wie Googles E-E-A-T Framework (Experience, Expertise, Authoritativeness, Trustworthiness) SEO-Praktikern ein Denkmodell für Qualitätsbewertung gab, gibt T.R.U.S.T. GEO-Praktikern ein Diagnosemodell für KI-Sichtbarkeit:

- T — Technik (Technical)

- R — Relevanz (Relevance)

- U — User (Users)

- S — Signale (Signals)

- T — Trust (Vertrauen)

Jede Säule adressiert einen unterschiedlichen Fehlermodus. Wenn Ihre Sichtbarkeit sinkt, auditieren Sie gegen T.R.U.S.T., um zu identifizieren, welche Säule bricht — und beheben es dann systematisch, anstatt Spaghetti an die Wand zu werfen.

Inhaltsverzeichnis

- Warum Frameworks in GEO wichtig sind

- T — Technik: Kann KI auf Ihre Daten zugreifen?

- R — Relevanz: Passt Ihr Content zur Suchintention?

- U — User: Lösen Sie Aufgaben, nicht nur Klicks?

- S — Signale: Wer sagt noch, dass Sie gut sind?

- T — Trust: Warum sollte KI Ihnen glauben?

- Drops diagnostizieren: Der Entscheidungsbaum

- Ihre Marke gegen T.R.U.S.T. bewerten

- Fallstudie: Das Framework anwenden

- FAQ

Warum Frameworks in GEO wichtig sind

Die KI-Suchlandschaft ist genuinely komplex. Ihre Sichtbarkeit wird beeinflusst durch Trainingsdaten-Zusammensetzung, Echtzeit-Retrieval-Qualität, Entity-Erkennung, System-Prompt-Beschränkungen, Modell-Temperatur, Konversationskontext und mehr.

Ohne Framework optimieren Sie einzelne Variablen isoliert — wie den Bass an einer Stereoanlage zu justieren, ohne den Song zu verstehen. Mit Framework sehen Sie den vollständigen Mix und können informierte Anpassungen vornehmen.

Forschung aus dem MIT Computer Science and Artificial Intelligence Laboratory (CSAIL) hat gezeigt, dass systematische Diagnoseansätze Ad-hoc-Fehlerbehebung in komplexen adaptiven Systemen um den Faktor 3-5× übertreffen (Sontag & Shah, „Causal Identification in Complex Systems," 2023). T.R.U.S.T. wendet dieses Prinzip auf GEO an.

T — Technik: Kann KI auf Ihre Daten zugreifen?

Die erste Säule ist die fundamentalste und die am häufigsten übersehene. Wenn KI-Crawler physisch nicht auf Ihren Content zugreifen können, spielt nichts anderes eine Rolle.

Die Technik-Checkliste

| Prüfung | Frage | Ressource |

|---|---|---|

| robots.txt | Sind GPTBot, ClaudeBot und PerplexityBot erlaubt? | Robots.txt für KI-Leitfaden |

| llms.txt | Haben Sie eine maschinenlesbare Content-Karte? | Was ist llms.txt? |

| Seitengeschwindigkeit | Kann Ihr Content innerhalb der RAG-Timeout-Limits (~2-5 Sekunden) abgerufen werden? | Google PageSpeed Insights |

| Rendering | Ist Ihr Content im HTML-Quellcode oder hinter JavaScript/SPA versteckt? | Seitenquelltext-Test |

| Canonical Tags | Folgen KI-Crawler den richtigen kanonischen URLs? | Site-Audit-Tools |

Warum das jetzt wichtiger ist

Traditionelle Suchmaschinen wie Google investierten Jahrzehnte in ausgefeilte Rendering-Pipelines, die JavaScript ausführen, Redirects folgen und Content aus komplexen SPAs extrahieren können. KI-Crawler sind vergleichsweise primitiv. Viele arbeiten wie der frühe Googlebot der 2000er: Sie lesen rohes HTML, folgen einfachen Links und ziehen weiter.

Wenn Ihr Content client-seitig mit React gerendert wird, aber kein Server-Side Rendering oder statische Generierung hat, könnten KI-Crawler eine leere Seite sehen. Forschung aus der Ahrefs 2024 AI Crawling Study ergab, dass 23% der Enterprise-Sites versehentlich mindestens einen großen KI-Bot durch fehlkonfigurierte robots.txt oder technische Barrieren blockieren.

Eine technische Störung diagnostizieren

Symptom: Plötzlicher, drastischer Sichtbarkeitseinbruch über alle KI-Modelle gleichzeitig.

Ursache: Meist ein Deployment, das robots.txt geändert hat, eine CDN-Fehlkonfiguration oder eine Migration, die Server-Side Rendering unterbrochen hat.

Fix: Notfall-Audit aller Zugangspunkte. robots.txt prüfen, mit curl testen, was KI-Bots sehen, verifizieren, dass llms.txt zugänglich ist.

R — Relevanz: Passt Ihr Content zur Suchintention?

Technischer Zugang ist notwendig, aber nicht hinreichend. Sobald KI Ihren Content lesen kann, stellt sich die Frage: findet sie, was sie sucht?

Semantische Relevanz vs. Keyword-Matching

Traditionelles SEO hat uns in Keyword-Optimierung geschult. GEO erfordert semantische Relevanz — Ihr Content muss zur Bedeutung der Anfrage passen, nicht nur zu den Worten.

LLMs verarbeiten Text durch Embedding-Vektoren — mathematische Darstellungen von Bedeutung in hochdimensionalem Raum. Die „Distanz" Ihres Contents zur Anfrage in diesem Vektorraum bestimmt die Retrieval-Relevanz. Wie Reimers & Gurevych demonstriert haben („Sentence-BERT: Sentence Embeddings using Siamese BERT-Networks," EMNLP 2019), clustert semantisch ähnlicher Content zusammen, unabhängig von der exakten Wortwahl.

Implikation: Für KI zu schreiben bedeutet, das semantische Territorium eines Themas abzudecken, nicht nur Ziel-Keywords einzustreuen. Wenn jemand fragt „Wie verbessere ich die Präsenz meiner Marke in ChatGPT?", muss Ihr Content Konzepte wie KI-Sichtbarkeit, Model Polling, Zitierungswahrscheinlichkeit und Entity-Erkennung abdecken — auch wenn diese exakten Phrasen nicht in der Anfrage vorkommen.

Kontextfenster-Positionierung

Unser Kontextfenster-Optimierungsleitfaden behandelt dies im Detail, aber die Schlüsselerkenntnisse aus Liu et al.s „Lost in the Middle"-Forschung sind es wert, wiederholt zu werden:

- Modelle schenken Information am Anfang und Ende ihres Kontextfensters mehr Aufmerksamkeit

- Information in der Mitte geht „verloren" — sie erhält buchstäblich niedrigere Aufmerksamkeitsgewichte

- Schlüsselaussagen voranstellen erhöht ihre Wahrscheinlichkeit, zitiert zu werden

Aktualität und Frische

Für RAG-basierte Systeme wie Perplexity ist Content-Frische wichtig. Forschung von Microsoft (Kasai et al., „RealTime QA," 2022) zeigt, dass Retrieval-Systeme bei aktuellen Anfragen stark kürzlich aktualisierten Content bevorzugen.

Aktion: Aktualisieren Sie Ihre Schlüsselseiten regelmäßig. Selbst kleine Auffrischungen (aktualisierte Statistiken, Referenzen auf das aktuelle Jahr) signalisieren dem Retrieval-System Aktualität.

U — User: Lösen Sie Aufgaben, nicht nur Klicks?

Das „U" ist möglicherweise die zukunftsweisendste Säule. Da KI sich von Fragen-Beantworten zu Aufgaben-Erledigung entwickelt — durch autonome KI-Agenten — muss Ihr Content Aktionen bedienen, nicht nur Information.

Der Wandel von Information zu Aufgabenerfüllung

Wenn ein Nutzer ChatGPT fragt „Buche mir ein Restaurant in München für Freitagabend", will die KI keine Liste von 10 Restaurants zeigen. Sie will die Aufgabe erledigen:

- Verfügbarkeit finden

- Präferenzen abgleichen

- Reservierung vornehmen

- Details bestätigen

Wenn Ihr Restaurant ein API-zugängliches Buchungssystem, strukturierte Verfügbarkeitsdaten und klare Preise hat — sind Sie für Aufgabenerfüllung optimiert. Wenn Sie eine schöne PDF-Speisekarte und eine „Rufen Sie uns an"-Telefonnummer haben — sind Sie für den Agenten unsichtbar.

User-Experience-Signale

Selbst bei Informationsanfragen zählen User-Engagement-Signale. Wenn Nutzer konsistent von KI-Zitierungen zu Ihrer Website durchklicken und Zeit damit verbringen zu lesen, verstärkt diese positive Feedback-Schleife Ihre Sichtbarkeit.

| Signal | Impact | Optimierung |

|---|---|---|

| Durchklick von Zitierung | Hoch | Überzeugende Meta-Beschreibungen und Seitentitel schreiben |

| Verweildauer | Mittel | Genuinely wertvollen, tiefgehenden Content erstellen |

| Absprungrate | Mittel | Sicherstellen, dass Content das Versprechen der KI einlöst |

| Aufgabenerfüllung | Sehr hoch | Aktionen ermöglichen (Buchen, Kaufen, Herunterladen) |

Forschung zum Zero-Click-Verhalten (SparkToro, „Zero-Click Search Study," 2024) zeigt, dass obwohl die Gesamt-Klickraten sinken, die Qualität der verbleibenden Klicks steigt. Nutzer, die von KI-Empfehlungen durchklicken, haben hohe Kaufabsicht — und Plattformen bemerken das.

S — Signale: Wer sagt noch, dass Sie gut sind?

Die vierte Säule adressiert externe Korroboration — das KI-Äquivalent von Backlinks, aber breiter und nuancierter.

Warum Signale Eigenwerbung überwiegen

Ein LLM, das Ihre Marke bewertet, liest nicht nur Ihre Website. Es liest, was alle über Sie sagen. Wenn Ihre Website behauptet „Wir sind das beste CRM für Startups", aber G2-Bewertungen sagen „Furchtbarer Kundenservice" und Reddit-Threads sagen „Finger weg" — wird die KI den Konsens widerspiegeln, nicht Ihr Marketing-Material.

Das ist das Prinzip der Multi-Quellen-Triangulation, umfangreich dokumentiert in der Knowledge-Graph-Literatur (Dong et al., „Knowledge Vault: A Web-Scale Approach to Probabilistic Knowledge Fusion," KDD 2014). KI weist Fakten, die über mehrere unabhängige Quellen bestätigt werden, höheres Vertrauen zu.

Signalquellen nach KI-Gewicht

| Quellentyp | KI-Gewicht | Ihre Strategie |

|---|---|---|

| Wikipedia | ★★★★★ | Genaue Wikipedia-Präsenz pflegen |

| Akademische Zitierungen | ★★★★★ | Forschung veröffentlichen, von Papers zitiert werden |

| Bewertungsplattformen (G2, Capterra) | ★★★★ | Bewertungsprofile aktiv pflegen |

| ★★★★ | Authentische Community-Präsenz aufbauen (Reddit-Strategie) | |

| Branchenpresse | ★★★★ | Berichterstattung verdienen, nicht nur bezahlte Platzierungen |

| Social Media | ★★ | Nützlich für Aktualitätssignale, weniger für Autorität |

| Eigener Blog | ★★ | Wichtig, aber allein nicht ausreichend |

Stimmung als Signal

Es reicht nicht, erwähnt zu werden. Sie müssen positiv erwähnt werden. Unsere KI-Sichtbarkeits-Score-Methodik trackt nicht nur Zitierungshäufigkeit, sondern auch Stimmung — denn ein LLM, das Ihre Marke „kennt", aber mit negativen Erfahrungen assoziiert, wird aktiv gegen Sie empfehlen.

Enterprise-Organisationen tracken zunehmend die Markenstimmung über KI-Modelle als Teil ihrer Corporate-Reputationsmanagement-Strategie.

T — Trust: Warum sollte KI Ihnen glauben?

Die letzte Säule ist der Schlussstein. Trust ist das kumulative Ergebnis aller anderen Säulen, hat aber auch eigene unabhängige Treiber.

Autorität und Autorenschaft

Googles E-E-A-T betont „Erfahrung" und „Expertise." KI-Modelle gehen weiter. Forschung des Allen Institute for AI (Wadden et al., „SciFact: Joint Scientific Document Retrieval and Fact-Checking," EMNLP 2020) demonstriert, dass LLMs die Quellglaubwürdigkeit bewerten, wenn sie konkurrierende Behauptungen gewichten.

Praktische Implikationen:

- Benannte Autoren: Content mit benannten, qualifizierten Autoren wird höher gewichtet als anonyme Firmenblogs

- Institutionelle Zugehörigkeit: Eine Studie, veröffentlicht von „MIT-Forschern", hat mehr Gewicht als eine von „unserem Datenteam"

- Zitierungsnetzwerke: Wenn Ihr Content glaubwürdige Quellen zitiert und glaubwürdige Quellen Sie zitieren, schaffen Sie eine Vertrauensschleife

YMYL: Der Vertrauens-Gatekeeper

Für Gesundheits-, Finanz-, Rechts- und Sicherheits-Content — was KI-Systeme als YMYL (Your Money or Your Life) klassifizieren — ist Trust nicht nur ein Ranking-Faktor. Es ist ein Gatekeeper. Modelle werden unvertrauenswürdigen Content in diesen Kategorien aktiv unterdrücken, um Haftungsrisiken zu reduzieren.

Wenn Sie in einem YMYL-Bereich operieren, ist die Trust-Säule nicht optional — sie ist existenziell.

Konsistenz baut Vertrauen auf

Trust verdichtet sich über die Zeit. Eine Marke, die konsistent präsent, konsistent genau und konsistent über Modellversionen hinweg zitiert ist, entwickelt eine „Knowledge-Graph-Klebrigkeit", die neue Marktteilnehmer nicht über Nacht replizieren können.

Deshalb ist Entity-SEO so wichtig. Starke Entities überdauern Modell-Updates. Schwache Entities driften und verschwinden.

Drops diagnostizieren: Der Entscheidungsbaum

Wenn Ihre KI-Sichtbarkeit sinkt, keine Panik. Auditieren Sie methodisch:

| Symptom | Erster Check | Wahrscheinliche Säule |

|---|---|---|

| Plötzlicher Einbruch, alle Modelle | Technischer Zugang (robots.txt, Site down?) | Technik |

| Gradueller Rückgang, Kategorie-Anfragen | Content-Frische, semantische Ausrichtung | Relevanz |

| Sichtbar aber niedriger Durchklick | User Experience, Content-Qualität | User |

| Wettbewerber steigt, Sie stagnieren | Externe Erwähnungen, Bewertungsprofile | Signale |

| Volatil, modellabhängig | Autoritätsmarker, Entity-Präsenz | Trust |

Ihre Marke gegen T.R.U.S.T. bewerten

Führen Sie diese schnelle Selbstbewertung durch (bewerten Sie jede Säule 1-5):

| Säule | Note 1 (Schwach) | Note 5 (Stark) |

|---|---|---|

| Technik | KI-Crawler teilweise blockiert | Voller Zugang + llms.txt + Schema |

| Relevanz | Generischer Content, Keyword-Stuffing | Semantische Abdeckung, vorangestellte Aussagen, frischer Content |

| User | Nur Information, keine Aktionen | Aufgabenermöglichend, API-zugänglich, strukturierte Daten |

| Signale | Nur Eigenwerbung | Wikipedia + Bewertungen + Reddit + Presse |

| Trust | Anonymer Blog, keine Zitierungen | Benannte Autoren, zitierte Quellen, Branchenautorität |

Punktzahl 20-25: Sie sind wettbewerbsfähig. Fokussieren Sie sich auf Weiterentwicklung. Punktzahl 15-19: Sie haben Lücken. Priorisieren Sie die schwächste Säule. Punktzahl unter 15: Grundlagenarbeit nötig. Beginnen Sie mit Technik.

Fallstudie: Das Framework anwenden

Ein von AICarma getracktes B2B-SaaS-Unternehmen erschien in 45% der relevanten ChatGPT-Anfragen, aber nur in 12% der Perplexity-Anfragen. Mit T.R.U.S.T.:

- Technik: Perplexity verlässt sich auf Echtzeit-Crawling. Ihre Site hatte

PerplexityBotin robots.txt blockiert. (Behoben → T-Säule.) - Relevanz: Ihre Landing Pages waren marketing-lastig mit begrenzter semantischer Tiefe. (Technische Dokumentation hinzugefügt → R-Säule.)

- Signale: Keine Präsenz auf Reddit oder Stack Overflow. (Authentisches Community-Engagement aufgebaut → S-Säule.)

Ergebnis: Perplexity-Sichtbarkeit verbesserte sich von 12% auf 38% innerhalb von 6 Wochen. ChatGPT blieb stabil. Gesamt-KI-Sichtbarkeits-Score stieg um 22 Punkte.

FAQ

Wie unterscheidet sich T.R.U.S.T. von Googles E-E-A-T?

E-E-A-T ist ein Qualitätsbewertungs-Framework, das für menschlich kuratierte Suchrankings konzipiert ist. T.R.U.S.T. ist ein Diagnose- und Optimierungsframework für probabilistische KI-Systeme. Es deckt technische Zugänglichkeit, Aufgabenerfüllung und externe Korroboration ab — Dimensionen, die E-E-A-T nicht adressiert, weil sie für traditionelle Suche nicht relevant waren.

Mit welcher Säule sollte ich anfangen?

Beginnen Sie immer mit Technik. Wenn KI-Crawler nicht auf Ihren Content zugreifen können, spielt nichts anderes eine Rolle. Nach Technik priorisieren Sie die Säule, die in Ihrer Selbstbewertung am niedrigsten abgeschnitten hat.

Wie oft sollte ich ein T.R.U.S.T.-Audit durchführen?

Wir empfehlen ein monatliches umfassendes Audit und wöchentliches Monitoring der Schlüsselindikatoren. Wie in unserem GEO-Schwungrad-Leitfaden beschrieben, erkennt kontinuierliches Monitoring Probleme schneller als periodische Audits.

Gilt T.R.U.S.T. für alle Branchen?

Ja, aber die Säulengewichtung variiert. Für YMYL-Branchen (Gesundheitswesen, Finanzwesen) trägt die Trust-Säule unverhältnismäßiges Gewicht. Für SaaS-Unternehmen sind Signale und Relevanz tendenziell die größten Differenzierungsfaktoren. Für lokale Unternehmen sind Technik- und User-Säulen kritisch.

Kann ich T.R.U.S.T. für Wettbewerbsanalysen verwenden?

Absolut. Bewerten Sie Ihre drei größten Wettbewerber gegen das Framework. Wo sie schwach und Sie stark sind — das ist Ihr Wettbewerbsvorteil. Wo sie stark und Sie schwach sind — das ist Ihre Priorität. Unser Wettbewerbsintelligenz-Leitfaden ergänzt T.R.U.S.T. mit spezifischen Wettbewerbs-Tracking-Methodologien.