Les Trois Internets : Optimiser pour les Robots, les Agents et les Humains en 2026

Dernière mise à jour : 15 February 2025

Permettez-moi de vous poser une question qui pourrait piquer un peu : Pour qui votre site web est-il vraiment construit ?

Si vous avez répondu « nos clients », vous n'avez qu'un tiers de la bonne réponse. Et ces deux tiers manquants pourraient expliquer pourquoi votre trafic organique plafonne, pourquoi votre marque n'apparaît pas dans les recommandations de ChatGPT, et pourquoi vos concurrents semblent être partout pendant que vous luttez pour être visible.

Voici la vérité inconfortable que les marketeurs avant-gardistes découvrent en 2026 : Votre site web ne sert pas un seul public. Il en sert trois. Nous appelons ce framework « Les Trois Internets », et le comprendre fait la différence entre prospérer à l'ère de l'IA et sombrer lentement dans l'obscurité digitale.

Table des Matières

- Que Sont Les Trois Internets ?

- L'Internet des Robots : Votre Couche Fondation

- L'Internet des Agents : Les Nouveaux Intermédiaires

- L'Internet Humain : Là Où l'Émotion Gagne Encore

- Pourquoi le Design Machine-First Aide Réellement les Humains

- La Matrice d'Optimisation des Trois Internets

- Exemple Concret : Comment une Entreprise SaaS a Triplé sa Visibilité IA

- Votre Plan d'Action sur 30 Jours

- FAQ

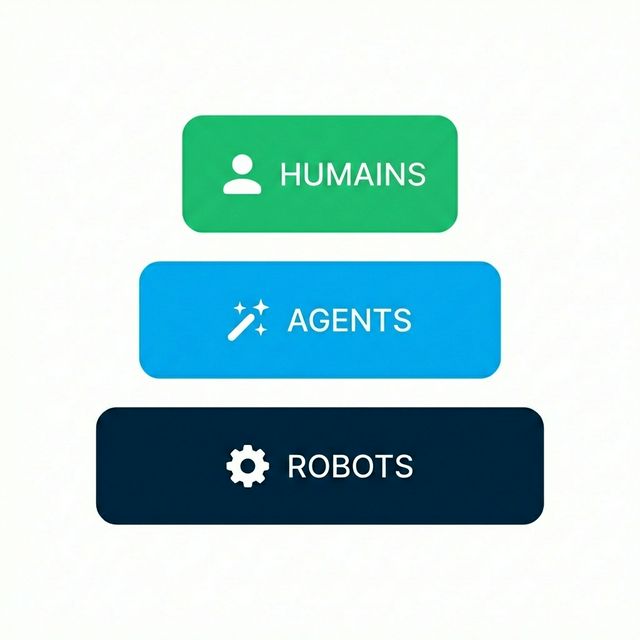

Que Sont Les Trois Internets ?

Le concept des « Trois Internets » fournit un framework stratégique pour comprendre la visibilité digitale moderne. Imaginez votre site web comme un bâtiment avec trois entrées différentes, chacune conçue pour un type de visiteur complètement différent.

La Hiérarchie de l'Accès Digital

| Couche Internet | Utilisateurs Principaux | Focus d'Optimisation Clé |

|---|---|---|

| Robots | Googlebot, GPTBot | Structure, vitesse, clarté |

| Agents | ChatGPT, Gemini, Perplexity | Faits, contexte, citations |

| Humains | Vos clients réels | Solutions, confiance, émotion |

La plupart des entreprises consacrent 95 % de leurs ressources à l'Internet Humain en ignorant complètement les deux couches qui contrôlent réellement l'accès à ces humains. C'est comme construire une magnifique boutique mais oublier de la mettre sur une carte.

La Hiérarchie de l'Accès Digital

Voici ce que la plupart des marketeurs ne comprennent pas : ces trois internets sont organisés en hiérarchie.

- Les Robots doivent crawler et indexer votre contenu en premier

- Les Agents récupèrent et synthétisent ensuite ce contenu pour les utilisateurs

- Les Humains voient finalement la version filtrée, résumée et recommandée

Si vous échouez à la couche un, les couches deux et trois n'arrivent jamais. Si vous échouez à la couche deux, les humains ne vous trouveront de moins en moins car ils demandent à l'IA au lieu de googler.

L'Internet des Robots : Votre Couche Fondation

Soyons brutalement honnêtes : les robots se moquent de vos titres astucieux, de vos belles photographies ou de votre histoire de marque émouvante. Ils se soucient d'une seule chose : Puis-je comprendre de quoi parle cette page, rapidement et précisément ?

Le Langage des Robots

Les robots parlent en données structurées. Alors que les humains lisent votre prose, les robots lisent votre balisage Schema. Voyez le Schema comme une couche de traduction entre le langage humain et le langage machine.

Voici ce qu'un robot « voit » quand il visite votre page produit :

{

"@type": "Product",

"name": "AI Analytics Pro",

"description": "Monitoring en temps réel des mentions de marque dans ChatGPT, Gemini et Claude",

"offers": {

"price": "299",

"priceCurrency": "USD"

}

}

Sans ces données structurées, le robot doit deviner le sujet de votre page en analysant votre HTML. Et devinez quoi ? Les robots sont mauvais pour deviner. Ils sont aussi impatients — si votre page met plus de 3 secondes à charger, ils pourraient ne pas attendre.

Les Trois Domaines Critiques d'Optimisation Robot

1. Efficacité de Crawl

Votre fichier robots.txt est votre videur à la porte. Il dit aux robots dans quelles salles ils peuvent entrer et lesquelles sont interdites. En 2026, vous devez réfléchir attentivement aux bots IA que vous autorisez :

| Nom du Bot | Propriétaire | Objectif | Devez-vous l'Autoriser ? |

|---|---|---|---|

| GPTBot | OpenAI | Données d'entraînement | Oui, pour les pages de marque |

| ChatGPT-User | OpenAI | Navigation en direct | Absolument oui |

| Google-Extended | Entraînement Gemini | Oui pour la visibilité | |

| ClaudeBot | Anthropic | Entraînement Claude | Oui pour la visibilité |

| CCBot | Common Crawl | Construction de dataset | Dépend de vos préoccupations de PI |

2. Architecture du Site

Les robots pensent en liens. Si vos pages les plus importantes sont enfouies à 6 clics de profondeur, les robots leur assignent une importance moindre. La règle de base : chaque page importante devrait être atteignable en 3 clics ou moins depuis votre page d'accueil.

3. Profondeur des Données Structurées

N'ajoutez pas juste du Schema basique. Superposez-le. Imbriquez-le. Connectez-le. Votre schema Organisation devrait lier à votre schema Produit, qui lie à votre schema Avis. Cela crée un graphe d'entités riche que robots et agents peuvent parcourir.

L'Internet des Agents : Les Nouveaux Intermédiaires

C'est là que les choses deviennent intéressantes — et où la plupart des entreprises échouent spectaculairement.

Les agents IA autonomes (comme ChatGPT, Perplexity et Gemini) ne font pas que indexer votre contenu comme les robots traditionnels. Ils le comprennent, le synthétisent et le recommandent aux humains. Ce sont les nouveaux intermédiaires entre votre site web et vos clients.

Quand un utilisateur demande à Perplexity : « Quel est le meilleur CRM pour une équipe remote de 50 personnes ? », l'agent ne liste pas juste 10 liens bleus. Il analyse des dizaines de sources, se forge une opinion et fait une recommandation spécifique.

Si vous n'êtes pas dans cette recommandation, vous pourriez aussi bien ne pas exister.

Ce que les Agents Veulent Vraiment

Les agents essaient de répondre aux questions avec précision tout en minimisant le risque d'hallucination. Ils préfèrent les sources qui offrent :

| Préférence de l'Agent | Pourquoi C'est Important | Comment Optimiser |

|---|---|---|

| Clarté sémantique | Réduit la mauvaise interprétation | Langage clair, sans jargon |

| Faits vérifiables | Réduit le risque d'hallucination | Citer les sources, inclure des données |

| Capacité transactionnelle | Permet de passer à l'action | APIs, widgets de réservation, tarifs clairs |

| Consensus élevé | Renforce la confiance | Validation tierce, avis |

Le Score de Visibilité : Votre Nouvelle Métrique North Star

En SEO traditionnel, vous suiviez les classements. En optimisation pour les agents, vous suivez votre Score de Visibilité — le pourcentage de prompts pertinents où votre marque apparaît dans la réponse de l'IA.

Voici un framework pour y réfléchir :

- 0-10 % de visibilité : Vous êtes invisible. Action urgente nécessaire.

- 10-30 % de visibilité : Vous existez mais n'êtes pas de confiance. Renforcez la force d'entité.

- 30-50 % de visibilité : Vous êtes compétitif. Concentrez-vous sur la différenciation.

- 50 %+ de visibilité : Vous dominez. Maintenez et défendez.

La plupart des marques sont choquées de découvrir qu'elles sont dans la catégorie 0-10 %, même si elles sont #1 sur Google pour leurs mots-clés principaux. C'est le paradoxe des Trois Internets : le succès en SEO traditionnel ne se traduit pas automatiquement en visibilité agent.

L'Internet Humain : Là Où l'Émotion Gagne Encore

Ne confondez pas notre emphase sur les machines avec un mépris des humains. C'est tout le contraire — en optimisant pour les robots et les agents, vous construisez essentiellement une voie rapide VIP qui livre des prospects parfaitement qualifiés à votre expérience humaine.

Ce que les Humains Veulent et que les Machines ne Peuvent Pas Fournir

Ironiquement, à mesure que l'IA génère plus de contenu, les signaux humains authentiques deviennent plus précieux :

- Histoires authentiques : Des récits « Comment nous avons construit cela » que l'IA ne peut pas fabriquer

- Recherche originale : Des données et insights qui n'existent pas ailleurs

- Communauté : Forums, commentaires, contenu généré par les utilisateurs

- Personnalité : Une voix qui est distinctement la vôtre

Les marques qui gagnent l'Internet Humain en 2026 sont celles qui redoublent d'efforts sur ce qui les rend irremplaçables. L'IA peut résumer les fonctionnalités de vos concurrents, mais elle ne peut pas répliquer l'histoire d'origine de votre fondateur ou la passion de votre communauté.

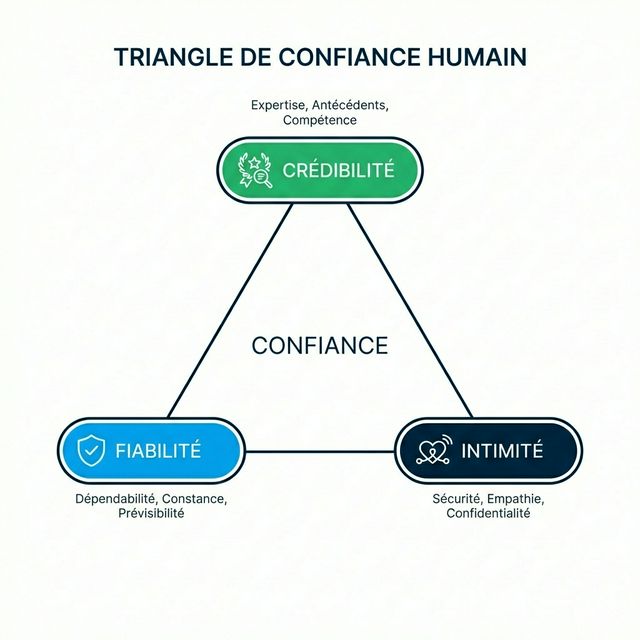

Le Triangle de Confiance

La conversion humaine dépend de trois facteurs formant un triangle :

- Crédibilité : Savez-vous de quoi vous parlez ? (Signaux d'expertise)

- Fiabilité : Tiendrez-vous vos promesses ? (Preuve sociale, avis)

- Intimité : Comprenez-vous moi ? (Personnalisation, empathie)

Les agents IA peuvent vérifier votre crédibilité en vérifiant les faits. Ils peuvent évaluer la fiabilité par l'agrégation d'avis. Mais l'intimité ? C'est là que l'expérience artisanale humaine règne encore en maître.

Pourquoi le Design Machine-First Aide Réellement les Humains

Voici l'insight contre-intuitif qui change tout : optimiser pour les machines rend votre expérience humaine meilleure, pas pire.

Réfléchissez-y :

- Les données structurées vous forcent à être clair sur ce que vous offrez

- Des vitesses de page rapides améliorent la patience humaine et la conversion

- Une architecture de site logique aide aussi les humains à naviguer

- La clarté sémantique rend votre contenu plus lisible

L'entreprise qui excelle en optimisation machine fournit souvent une expérience humaine supérieure comme effet secondaire. Ce n'est pas un compromis — c'est un multiplicateur.

La Matrice d'Optimisation des Trois Internets

Voici une matrice pratique pour auditer votre état actuel :

| Domaine d'Optimisation | Internet Robot | Internet Agent | Internet Humain |

|---|---|---|---|

| Vitesse | Core Web Vitals | Temps de réponse API | Perception de chargement |

| Structure | Balisage Schema | Chunks RAG-friendly | Navigation claire |

| Contenu | Lisible par machine | Faits citables | Storytelling émotionnel |

| Confiance | SSL, uptime | Vérification d'entité | Avis, témoignages |

| Action | Chemins de crawl | APIs transactionnelles | CTAs, formulaires |

Notez-vous de 1 à 5 dans chaque cellule. Toute cellule en dessous de 3 est une priorité à corriger.

Exemple Concret : Comment une Entreprise SaaS a Triplé sa Visibilité IA

Laissez-moi vous parler d'une entreprise de logiciels B2B (nom masqué pour confidentialité) qui est venue nous voir avec un problème frustrant. Ils étaient #1 sur Google pour « alternatives logiciel de gestion de projet » mais invisibles dans ChatGPT.

Le Diagnostic :

- Leur robots.txt bloquait GPTBot (accidentellement après une mise à jour « sécurité »)

- Leurs tarifs étaient cachés derrière un formulaire « Contactez les Ventes » (les agents détestent ça)

- Leur balisage Schema était minimal — juste Organisation, pas de Produit ni FAQ

- Leur contenu était du langage marketing édulcoré, pas des données de comparaison denses en faits

La Prescription :

- Correction du robots.txt pour autoriser les crawlers IA

- Publication de pages tarifaires claires avec schema

Offer - Création de tableaux de comparaison détaillés avec balisage structuré

- Ajout de sections FAQ avec schema FAQ

- Référencement sur G2, Capterra et les principaux annuaires logiciels

Les Résultats (90 jours plus tard) :

- Score de Visibilité IA : 4 % → 47 %

- Le volume de recherche de marque a augmenté de 35 % (les gens ont entendu parler d'eux via l'IA)

- Demandes de démo du trafic référé par l'IA : taux de closing 3,2x plus élevé

La magie n'était pas une tactique isolée. C'était l'optimisation systématique à travers les trois internets.

Votre Plan d'Action sur 30 Jours

Prêt à optimiser pour les trois internets ? Voici votre feuille de route :

Semaine 1 : Fondation Robot

- [ ] Auditer votre robots.txt pour les permissions de bots IA

- [ ] Tester vos Core Web Vitals (objectif : tout au vert)

- [ ] Implémenter les schemas Organisation et Produit

- [ ] Créer ou mettre à jour votre sitemap XML

Semaine 2 : Optimisation Agent

- [ ] Identifier vos 10 meilleurs « prompts d'argent » (que devraient demander les utilisateurs pour vous trouver ?)

- [ ] Créer des pages FAQ ciblant ces prompts

- [ ] Ajouter des tableaux de comparaison avec données structurées

- [ ] Publier vos tarifs publiquement (pas de boîtes noires « Contactez les Ventes »)

Semaine 3 : Polish Humain

- [ ] Écrire ou mettre à jour votre histoire de fondateur

- [ ] Collecter et afficher des témoignages clients

- [ ] Créer des études de cas avec des métriques spécifiques

- [ ] Concevoir des appels à l'action clairs pour chaque page

Semaine 4 : Mesure & Itération

- [ ] Mettre en place le monitoring de visibilité IA (outils comme AICarma)

- [ ] Établir des métriques de référence sur les trois couches

- [ ] Identifier vos domaines les moins bien notés

- [ ] Prioriser les améliorations pour le mois 2

FAQ

Puis-je ignorer l'Internet des Agents et me concentrer sur le SEO traditionnel ?

Vous le pouvez, mais vous ignorerez un pourcentage croissant de la découverte. Gartner prédit que d'ici 2027, 50 % de toutes les recherches de produits commenceront avec un assistant IA plutôt qu'un moteur de recherche. Ignorer les agents signifie concéder la moitié du marché aux concurrents qui le prennent au sérieux.

Comment vérifier ma visibilité dans l'Internet des Agents ?

Vous pouvez utiliser des plateformes comme AICarma pour suivre la présence de votre marque dans les réponses IA. Les outils traditionnels de suivi de classement sont complètement aveugles à cette couche — ils ne mesurent que ce qu'ils ont toujours mesuré (les classements Google), manquant entièrement les nouveaux canaux de découverte.

Les données structurées sont-elles vraiment si importantes ?

Oui. Les données structurées sont le seul moyen de communiquer sans ambiguïté avec les LLMs. Sans elles, vous comptez sur l'IA pour « deviner » probabilistiquement ce que signifie votre contenu. Parfois elle devine juste. Souvent non. Avec le balisage Schema, vous donnez à la machine des instructions explicites plutôt que d'espérer le meilleur.

Quel est le ROI de l'optimisation pour les trois internets ?

D'après notre analyse, les entreprises qui optimisent systématiquement pour les trois internets constatent :

- 2-4x d'amélioration des scores de visibilité IA

- 25-40 % de réduction du syndrome de la marque invisible

- 15-30 % d'augmentation du trafic qualifié (visiteurs à intention plus élevée)

- De meilleurs taux de conversion (car les visiteurs sont pré-qualifiés par les recommandations IA)

Par où commencer si je suis dépassé ?

Commencez par le robots.txt. Il faut 5 minutes pour le vérifier et le mettre à jour. Puis passez au balisage Schema basique. Ces deux corrections seules peuvent déjà faire bouger les choses significativement, et elles sont la fondation sur laquelle tout le reste se construit.