Der vollständige Robots.txt-Leitfaden für KI-Crawler: Strategie & Vorlagen 2026

Letzte Aktualisierung: 5. September 2025

Es gibt eine Datei auf Ihrem Webserver, die Sie gerade Millionen an verlorenen Chancen kosten könnte. Sie ist nur wenige Kilobyte groß. Sie wurde wahrscheinlich vor Jahren eingerichtet und vergessen. Und im Jahr 2026 ist sie zum wichtigsten Governance-Dokument für Ihre Beziehung zur Künstlichen Intelligenz geworden.

Ich spreche von robots.txt.

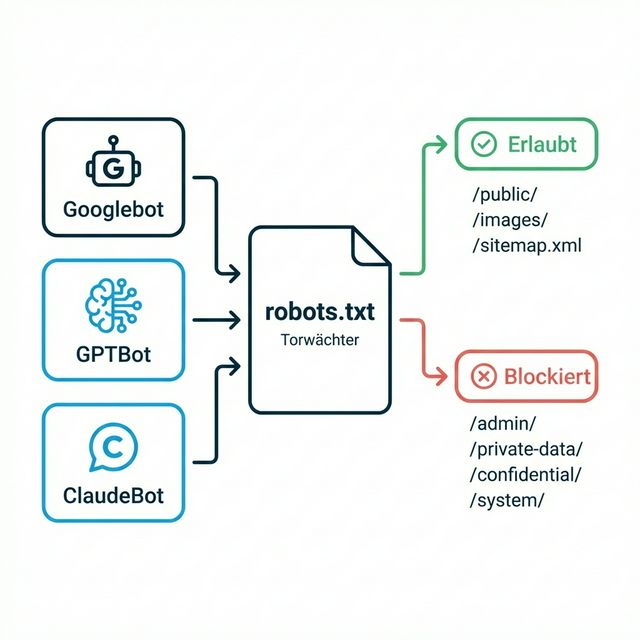

In den alten Zeiten von SEO war robots.txt einfach: Man erlaubte Googlebot und blockierte Spam-Crawler. Einrichten und vergessen. Aber heute klopfen Dutzende KI-Crawler — von OpenAI, Anthropic, Google, Apple, Meta und zahlreichen anderen — jeden Tag an Ihre digitale Tür. Ihre robots.txt-Datei bestimmt, ob sie hereinkommen, was sie über Ihre Marke erfahren, und letztendlich, ob Sie in den Köpfen von KI-Systemen existieren.

Die Entscheidung, die Sie hier treffen, wirkt sich auf jede KI-gestützte Suche aus, auf jede ChatGPT-Empfehlung, auf jede Gemini-Antwort. Machen Sie es falsch, und Sie wählen freiwillig das Unsichtbare-Marke-Syndrom. Machen Sie es richtig, und Sie öffnen einen direkten Kanal zu Milliarden von KI-gestützten Anfragen.

Lassen Sie uns das richtig machen.

Inhaltsverzeichnis

- Warum Robots.txt plötzlich wichtiger ist als je zuvor

- Die KI-Crawler-Landschaft: Wer klopft an Ihre Tür

- Der Blockieren-vs.-Erlauben-Entscheidungsbaum

- Die selektive Zugangsstrategie

- Robots.txt-Vorlagen zum Kopieren

- Häufige Fehler und wie Sie sie vermeiden

- So auditieren Sie Ihre aktuelle Robots.txt

- Jenseits von Robots.txt: Die llms.txt-Initiative

- Monitoring und Wartung

- FAQ

Warum Robots.txt plötzlich wichtiger ist als je zuvor

30 Jahre lang diente robots.txt einem primären Zweck: zu kontrollieren, wie Suchmaschinen Ihre Website crawlten. Es war ein einfacher Verkehrspolizist — diesen Bot durchlassen, jenen blockieren.

Aber hier ist, was sich geändert hat:

Die alte Welt (vor 2023)

- Ein wichtiger Crawler (Googlebot), der für 90% des organischen Traffics zählte

- Crawl = Index = Entdeckung (einfache Beziehung)

- Blockieren = Kein Ranking (offensichtliche Konsequenzen)

Die neue Welt (2024+)

- Dutzende bedeutender Crawler mit unterschiedlichen Zwecken

- Crawl ≠ Training ≠ Retrieval (komplexe Beziehungen)

- Blockieren = Komplexe Abwägungen (Training vs. Live-Suche vs. Datenschutz)

Die fundamentale Verschiebung ist: Das Blockieren eines KI-Crawlers hat jetzt Konsequenzen, die weit über traditionelle Suchrankings hinausgehen. Blockieren Sie GPTBot, und ChatGPTs Trainingsdaten erfahren nie von Ihren neuen Produkten. Blockieren Sie ChatGPT-User, und Sie verschwinden vollständig aus Live-KI-Suchen.

Die KI-Crawler-Landschaft: Wer klopft an Ihre Tür

Bevor Sie strategische Entscheidungen treffen, müssen Sie verstehen, wer Ihre Website besucht und warum:

Stufe 1: Die Hauptakteure

| User-Agent | Eigentümer | Primärer Zweck | Traffic-Auswirkung |

|---|---|---|---|

| GPTBot | OpenAI | Training zukünftiger GPT-Modelle | Zukünftiges ChatGPT-Wissen |

| ChatGPT-User | OpenAI | Live-Browsing für ChatGPT-Antworten | Sofortige ChatGPT-Sichtbarkeit |

| Google-Extended | Training von Gemini/KI-Übersichten | Zukünftiges Google-KI-Wissen | |

| Googlebot | Traditionelle Suchindexierung | Standard-Suchrankings | |

| ClaudeBot | Anthropic | Training von Claude-Modellen | Zukünftiges Claude-Wissen |

| Applebot-Extended | Apple | Training von Apple Intelligence | Siri und Apple-KI |

Stufe 2: Aufstrebende Akteure

| User-Agent | Eigentümer | Primärer Zweck |

|---|---|---|

| PerplexityBot | Perplexity | Live-Suche + zukünftiges Training |

| cohere-ai | Cohere | Enterprise-KI-Training |

| Amazonbot | Amazon | Alexa + KI-Shopping |

| Meta-ExternalAgent | Meta | Meta-KI-Features |

| Bytespider | ByteDance | TikTok-Effekte + KI |

Stufe 3: Datenaggregatoren

| User-Agent | Eigentümer | Empfehlung |

|---|---|---|

| CCBot | Common Crawl | Bei IP-Bedenken blockieren |

| DataForSeoBot | DataForSEO | Normalerweise blockieren |

| Diffbot | Diffbot | Kontextabhängig |

Kritische Unterscheidung: Training vs. Retrieval

Das ist das wichtigste Konzept:

Training-Bots (GPTBot, ClaudeBot, Google-Extended):

- Crawlen Ihre Inhalte zur Aufnahme in zukünftiges Modelltraining

- Auswirkungen zeigen sich 3-12 Monate später, wenn neue Modelle veröffentlicht werden

- Blockieren verhindert zukünftiges Wissen über Ihre Marke

Retrieval-Bots (ChatGPT-User, PerplexityBot):

- Crawlen Ihre Inhalte in Echtzeit, um Nutzeranfragen zu beantworten

- Auswirkung ist sofort — blockieren Sie sie, und Sie verschwinden heute

- Diese Bots sollten Sie fast nie blockieren

Hybrid-Bots (Googlebot):

- Übernehmen sowohl traditionelle Indexierung als auch KI-Features

- Komplexere Auswirkungen bei Blockierung

Der Blockieren-vs.-Erlauben-Entscheidungsbaum

Sollten Sie KI-Crawler erlauben? Hier ist ein Entscheidungsframework:

Starten Sie mit Ihrem Geschäftsmodell

Ist Ihr Content Ihr primäres Produkt?

│

├─→ JA (Verlag, Datenanbieter, Nachrichtenseite)

│ │

│ └─→ Erwägen Sie, TRAINING-Bots zu blockieren (GPTBot, ClaudeBot)

│ ABER erlauben Sie RETRIEVAL-Bots (ChatGPT-User, PerplexityBot)

│ Dies schützt IP und erhält Sichtbarkeit

│

└─→ NEIN (Marke, die Produkte/Dienstleistungen verkauft)

│

└─→ ALLE KI-Crawler ERLAUBEN

Ihr Ziel ist maximale Sichtbarkeit über alle KI-Systeme

Die Abwägungsmatrix

| Entscheidung | Vorteile | Nachteile |

|---|---|---|

| Alle KI blockieren | Schützt IP, kein KI-Training mit Ihrem Content | Totale KI-Unsichtbarkeit, Verlust des zukünftigen Entdeckungskanals |

| Alle KI erlauben | Maximale Sichtbarkeit, volle KI-Reichweite | Kein IP-Schutz, keine Content-Kontrolle |

| Selektiv (Empfohlen) | Ausgewogener Schutz und Sichtbarkeit | Erfordert laufendes Management |

Wann blockieren (Vorsicht!)

Blockieren Sie Training-Bots NUR wenn:

- Ihr Content hinter einer Paywall steht, für die Nutzer bezahlen

- Sie ein großer Verlag mit echten IP-Bedenken sind

- Sie einen rechtlichen oder Compliance-Grund haben

Warnung: Viele Unternehmen blockieren KI-Crawler panisch aus vagen „Sicherheitsgründen". Das ist fast immer ein Fehler. Sofern Sie nicht die New York Times sind, überwiegt der Nachteil der Unsichtbarkeit die theoretischen IP-Bedenken bei Weitem.

Die selektive Zugangsstrategie

Der ausgefeilte Ansatz für 2026 ist nicht binär — er ist chirurgisch. So implementieren Sie ihn:

Strategie-Übersicht

| Content-Typ | Training-Bots | Retrieval-Bots | Grund |

|---|---|---|---|

| Produktseiten | Erlauben | Erlauben | Kern-Sichtbarkeit |

| Preisseiten | Erlauben | Erlauben | Agenten brauchen diese Daten |

| Über uns/Unternehmen | Erlauben | Erlauben | Entity-Aufbau |

| Blog-Content | Erlauben | Erlauben | Thought Leadership |

| Kundenportal | Blockieren | Blockieren | Datenschutz |

| Admin/API | Blockieren | Blockieren | Sicherheit |

| Nutzerdatenseiten | Blockieren | Blockieren | Compliance |

| Premium-Gated-Content | Training blockieren, Retrieval erlauben | Erlauben | Monetarisierungsschutz |

Implementierungsbeispiel

# Basis: Alle legitimen Bots erlauben

User-agent: *

Allow: /

# Standard-Sicherheit - Admin- und API-Bereiche blockieren

Disallow: /admin/

Disallow: /api/

Disallow: /private/

Disallow: /customer-portal/

# Alle OpenAI-Crawler für maximale Sichtbarkeit erlauben

User-agent: GPTBot

Allow: /

Disallow: /admin/

Disallow: /api/

Disallow: /private/

User-agent: ChatGPT-User

Allow: /

Disallow: /admin/

Disallow: /private/

# Googles KI-Training-Bot erlauben

User-agent: Google-Extended

Allow: /

Disallow: /admin/

Disallow: /private/

# Anthropics Crawler erlauben

User-agent: ClaudeBot

Allow: /

Disallow: /admin/

Disallow: /private/

# Apples KI-Training erlauben

User-agent: Applebot-Extended

Allow: /

Disallow: /admin/

Disallow: /private/

# Aggressive Datenscraper blockieren

User-agent: CCBot

Disallow: /

User-agent: DataForSeoBot

Disallow: /

Robots.txt-Vorlagen zum Kopieren

Hier sind sofort einsetzbare Vorlagen für gängige Szenarien:

Vorlage 1: Maximale KI-Sichtbarkeit (Die meisten Unternehmen)

Am besten für: B2B-SaaS, E-Commerce, Agenturen, Dienstleistungsunternehmen

# Konfiguration für maximale KI-Sichtbarkeit

# Für Marken, die von KI erkannt und empfohlen werden wollen

User-agent: *

Allow: /

Disallow: /admin/

Disallow: /api/

Disallow: /private/

Disallow: /checkout/

Disallow: /account/

# OpenAI - ChatGPT und Training

User-agent: GPTBot

Allow: /

User-agent: ChatGPT-User

Allow: /

# Google KI

User-agent: Google-Extended

Allow: /

# Anthropic - Claude

User-agent: ClaudeBot

Allow: /

# Apple Intelligence

User-agent: Applebot-Extended

Allow: /

# Perplexity

User-agent: PerplexityBot

Allow: /

# Sitemap-Referenz

Sitemap: https://ihredomain.de/sitemap.xml

Vorlage 2: Verlagsschutz (Content-Unternehmen)

Am besten für: Nachrichtenseiten, Premium-Verlage, Datenanbieter

# Verlagsschutz-Konfiguration

# Blockiert Training, erlaubt Live-Suchsichtbarkeit

User-agent: *

Allow: /

Disallow: /subscriber/

Disallow: /premium/

Disallow: /archive/

# Training blockieren, Live-Browsing erlauben

User-agent: GPTBot

Disallow: /

User-agent: ChatGPT-User

Allow: /

Disallow: /subscriber/

Disallow: /premium/

User-agent: Google-Extended

Disallow: /

User-agent: Googlebot

Allow: /

User-agent: ClaudeBot

Disallow: /

# Common Crawl blockieren (Trainingsdaten-Quelle)

User-agent: CCBot

Disallow: /

Sitemap: https://ihredomain.de/sitemap.xml

Vorlage 3: Hybrid-Ansatz (Analyse erforderlich)

Am besten für: Unternehmen mit gemischtem Content (teils öffentlich, teils proprietär)

# Hybrid-Konfiguration

# Selektiver Zugang basierend auf Content-Wert

User-agent: *

Allow: /

# Öffentlicher Content für alle erlaubt

# Homepage, Produktseiten, Blog, Über uns

# Standard-Allow deckt diese ab

# Proprietärer Content für Training-Bots blockiert

User-agent: GPTBot

Allow: /

Allow: /products/

Allow: /blog/

Allow: /about/

Disallow: /research/

Disallow: /whitepapers/

Disallow: /proprietary-data/

# Live-Browsing für meisten Content erlaubt

User-agent: ChatGPT-User

Allow: /

Disallow: /proprietary-data/

# Ähnliche Muster für andere KI-Bots...

User-agent: ClaudeBot

Allow: /

Allow: /products/

Allow: /blog/

Disallow: /research/

Disallow: /whitepapers/

Sitemap: https://ihredomain.de/sitemap.xml

Häufige Fehler und wie Sie sie vermeiden

Fehler 1: Versehentliches Blockieren

Das Problem: Ein Entwickler hat vor drei Jahren bei einer „Sicherheitsüberprüfung" Disallow: / für GPTBot hinzugefügt. Niemand hat es bemerkt. Ihr Unternehmen ist seitdem für ChatGPT-Training unsichtbar.

Die Lösung: Auditieren Sie Ihre robots.txt vierteljährlich. Setzen Sie Kalendererinnerungen. Behandeln Sie dies als Marketing-Dokument, nicht nur als technische Datei.

Fehler 2: ChatGPT-User zusammen mit GPTBot blockieren

Das Problem: Sie wollten KI-Training blockieren und haben daher GPTBot blockiert. Aber ChatGPT-User ist ein separater Bot für Live-Browsing. Jetzt sind Sie bei allen ChatGPT-Suchen unsichtbar.

Die Lösung: Verstehen Sie den Unterschied zwischen Training-Bots und Retrieval-Bots. Blockieren Sie sie separat basierend auf Ihren tatsächlichen Zielen.

Fehler 3: Gar keine Robots.txt

Das Problem: Ihre Website gibt einen 404-Fehler für robots.txt zurück. Manche Bots interpretieren dies als „alles erlaubt" (gut). Andere könnten verwirrt sein (schlecht). Sie haben keine Kontrolle.

Die Lösung: Haben Sie immer eine explizite robots.txt, selbst wenn sie nur „Allow: /" sagt.

Fehler 4: Robots.txt im Unterverzeichnis

Das Problem: Ihre robots.txt liegt unter /marketing/robots.txt statt /robots.txt. Crawler finden sie nicht.

Die Lösung: Robots.txt MUSS im Root liegen: ihredomain.de/robots.txt

Fehler 5: Übermäßiges Blockieren aus Angst

Das Problem: Die „KI ist beängstigend, blockieren wir alles"-Mentalität führt zu kategorieweiter Unsichtbarkeit.

Die Lösung: Fragen Sie sich: „Was ist der tatsächliche Schaden, wenn KI über meine Produktseiten Bescheid weiß?" Für die meisten Unternehmen lautet die Antwort „keiner." Der Schaden durch Unsichtbarkeit ist weit größer.

So auditieren Sie Ihre aktuelle Robots.txt

Hier ist ein systematischer Auditprozess:

Schritt 1: Aktuelle Datei aufrufen

Navigieren Sie im Browser zu ihredomain.de/robots.txt. Kopieren Sie den Inhalt.

Schritt 2: KI-Crawler-Regeln identifizieren

Suchen Sie nach diesen User-Agents:

- GPTBot

- ChatGPT-User

- Google-Extended

- ClaudeBot

- Applebot-Extended

- PerplexityBot

- CCBot

Schritt 3: Auf problematische Muster prüfen

| Muster | Problem | Lösung |

|---|---|---|

User-agent: GPTBot + Disallow: / |

Vollständige OpenAI-Training-Blockade | Entfernen, sofern nicht beabsichtigt |

User-agent: * + Disallow: / |

Blockiert alles | Selektive Regeln implementieren |

| Keine Erwähnung von KI-Bots | Verlässt sich auf Wildcard-Regeln | Explizite Allow-Regeln hinzufügen |

ChatGPT-User blockiert |

Live-Such-Unsichtbarkeit | Erlauben, außer in Extremfällen |

Schritt 4: Konfiguration testen

Verwenden Sie Googles robots.txt-Tester zur Syntaxvalidierung. Dann manuell überprüfen:

- Ist Ihre Homepage für GPTBot erlaubt?

- Ist Ihre Preisseite für ChatGPT-User erlaubt?

- Sind Admin-/Private-Bereiche blockiert?

Schritt 5: Bereitstellen und Überwachen

Änderungen vornehmen, bereitstellen und 2-4 Wochen überwachen. Beobachten Sie Veränderungen der KI-Sichtbarkeit (mit Tools wie AICarma).

Jenseits von Robots.txt: Die llms.txt-Initiative

Robots.txt sagt KI-Bots, wohin sie gehen KÖNNEN. Aber es gibt einen aufkommenden Standard, der ihnen sagt, was sie WISSEN SOLLTEN: llms.txt.

Während robots.txt Zugriffskontrolle regelt, geht es bei llms.txt um Informationspriorisierung. Stellen Sie sich vor, Sie geben der KI einen „Spickzettel" Ihrer wichtigsten Inhalte in maschinenoptimiertem Format.

Die beiden arbeiten zusammen:

- robots.txt: „Sie können auf diese Seiten zugreifen"

- llms.txt: „Das ist das Wichtigste, was Sie über uns verstehen sollten"

Monitoring und Wartung

Vierteljährliche Audit-Checkliste

- [ ] Robots.txt auf unautorisierte Änderungen prüfen

- [ ] Auf neue KI-User-Agents prüfen, die explizit adressiert werden sollten

- [ ] Sicherstellen, dass kritische Seiten (Preise, Produkte, Über uns) erlaubt sind

- [ ] Sichtbarkeit in ChatGPT, Claude und Gemini testen

- [ ] Server-Logs auf KI-Crawler-Aktivität prüfen

Laufendes Monitoring

Behalten Sie im Auge:

- Crawl-Frequenz: Besuchen KI-Bots Ihre Website tatsächlich?

- Neue User-Agents: Crawlt ein neuer KI-Dienst Ihre Seite?

- Sichtbarkeitsänderungen: Hat Blockieren/Erlauben Ihren KI-Sichtbarkeits-Score beeinflusst?

Wann aktualisieren

Aktualisieren Sie Ihre robots.txt wenn:

- Neue öffentliche Content-Bereiche gestartet werden

- Neue private/geschützte Bereiche erstellt werden

- Ein neuer bedeutender KI-Crawler auftaucht

- Sich Ihre Content-Strategie ändert

- Sie Hosting oder CMS-Plattform wechseln

FAQ

Entfernt das Blockieren von GPTBot mich sofort aus ChatGPT?

Nein. Das Blockieren von GPTBot verhindert nur zukünftiges Training. Ihre Marke erscheint weiterhin in Antworten basierend auf existierenden Trainingsdaten — aber diese Daten werden zunehmend veraltet. Das Blockieren von ChatGPT-User hingegen entfernt Sie sofort aus Live-„Browse with Bing"-Suchen.

Was ist Google-Extended und warum ist es von Googlebot getrennt?

Google-Extended ist ein Token, der kontrolliert, ob Ihr Content für Gemini/KI-Training verwendet wird, während die traditionelle Suchindexierung (Googlebot) unbeeinflusst bleibt. Googles Methode, Ihnen das Opt-out aus KI-Training zu ermöglichen, ohne Suchrankings zu opfern. Für die meisten Unternehmen sollten Sie beides erlauben.

Kann ich nur bestimmte Seiten für KI-Crawler blockieren?

Ja. Robots.txt funktioniert auf Verzeichnis- und Dateiebene. Sie können granulare Regeln erstellen: Allow: /blog/ aber Disallow: /blog/proprietary-research/. Verwenden Sie die spezifischsten Regeln für jede Content-Kategorie.

Wie oft aktualisieren KI-Unternehmen ihre Crawler-User-Agents?

Große Änderungen sind selten, aber sie passieren. OpenAI hat 2023 ChatGPT-User hinzugefügt. Google hat 2023 Google-Extended eingeführt. Rechnen Sie mit 1-2 neuen bedeutenden User-Agents pro Jahr, während sich die KI-Landschaft weiterentwickelt. Verfolgen Sie die Ankündigungen der KI-Unternehmen und Branchenpublikationen.

Wenn ich KI-Crawler bereits blockiert habe, ist es dann zu spät?

Nein. KI-Training wird periodisch aktualisiert. Wenn Sie jetzt entsperren, werden neue Trainingsläufe Ihren Content einschließen. Der Effekt ist nicht sofort — rechnen Sie mit 3-12 Monaten für die volle Auswirkung auf trainingsbasierte Modelle. Live-Such-Bots (ChatGPT-User, PerplexityBot) sehen Ihren Content sofort nach der Entsperrung.

Sollte ich robots.txt mit meiner Schema-Markup-Strategie koordinieren?

Absolut. Schema-Markup und robots.txt arbeiten zusammen. Robots.txt bringt den Crawler zu Ihrem Content; Schema-Markup stellt sicher, dass der Crawler Ihren Content akkurat versteht. Optimieren Sie beides für maximale KI-Sichtbarkeit.