Die drei Internets: Optimierung für Roboter, Agenten und Menschen in 2026

Letzte Aktualisierung: 15. February 2025

Erlauben Sie mir eine Frage, die ein wenig wehtun könnte: Für wen ist Ihre Website wirklich gebaut?

Wenn Sie „unsere Kunden" geantwortet haben, liegen Sie nur zu einem Drittel richtig. Und die fehlenden zwei Drittel könnten der Grund sein, warum Ihr organischer Traffic stagniert, warum Ihre Marke nicht in ChatGPT-Empfehlungen erscheint und warum Ihre Wettbewerber überall zu sein scheinen, während Sie darum kämpfen, gesehen zu werden.

Hier ist die unbequeme Wahrheit, die vorausschauende Marketer 2026 erkennen: Ihre Website bedient nicht ein Publikum. Sie bedient drei. Wir nennen dieses Framework „Die drei Internets", und es zu verstehen ist der Unterschied zwischen Gedeihen im KI-Zeitalter und langsamem Verschwinden in digitaler Unsichtbarkeit.

Inhaltsverzeichnis

- Was sind die drei Internets?

- Das Internet der Roboter: Ihre Fundament-Schicht

- Das Internet der Agenten: Die neuen Mittelsmänner

- Das menschliche Internet: Wo Emotion noch gewinnt

- Warum Machine-First-Design Menschen tatsächlich hilft

- Die Drei-Internets-Optimierungsmatrix

- Praxisbeispiel: Wie ein SaaS-Unternehmen seine KI-Sichtbarkeit verdreifachte

- Ihr 30-Tage-Aktionsplan

- FAQ

Was sind die drei Internets?

Das Konzept der „Drei Internets" bietet ein strategisches Framework zum Verständnis moderner digitaler Sichtbarkeit. Stellen Sie es sich so vor: Ihre Website ist ein Gebäude mit drei verschiedenen Eingängen, jeder für einen völlig anderen Besuchertyp gestaltet.

Die Hierarchie des digitalen Zugangs

| Internet-Schicht | Primäre Nutzer | Kernfokus der Optimierung |

|---|---|---|

| Roboter | Googlebot, GPTBot | Struktur, Geschwindigkeit, Klarheit |

| Agenten | ChatGPT, Gemini, Perplexity | Fakten, Kontext, Zitierungen |

| Menschen | Ihre tatsächlichen Kunden | Lösungen, Vertrauen, Emotion |

Die meisten Unternehmen stecken 95% ihrer Ressourcen in das menschliche Internet und ignorieren die zwei Schichten, die den Zugang zu diesen Menschen tatsächlich kontrollieren, komplett. Es ist, als würden Sie ein wunderschönes Geschäft bauen, aber vergessen, es auf irgendeine Karte zu setzen.

Die Hierarchie des digitalen Zugangs

Hier ist, was die meisten Marketer nicht verstehen: Diese drei Internets sind in einer Hierarchie angeordnet.

- Roboter müssen Ihren Content erst crawlen und indexieren

- Agenten rufen diesen Content dann ab und synthetisieren ihn für Nutzer

- Menschen sehen schließlich die gefilterte, zusammengefasste, empfohlene Version

Wenn Sie auf Schicht eins versagen, passieren Schicht zwei und drei nie. Wenn Sie auf Schicht zwei versagen, werden Menschen Sie zunehmend nicht finden, weil sie KI fragen statt zu googeln.

Das Internet der Roboter: Ihre Fundament-Schicht

Seien wir brutal ehrlich: Robotern sind Ihre cleveren Überschriften, Ihre schöne Fotografie oder Ihre emotionale Markengeschichte egal. Sie interessieren sich für eine Sache: Kann ich schnell und genau verstehen, worum es auf dieser Seite geht?

Die Sprache der Roboter

Roboter sprechen in strukturierten Daten. Während Menschen Ihre Prosa lesen, lesen Roboter Ihr Schema-Markup. Denken Sie an Schema als Übersetzungsschicht zwischen menschlicher Sprache und Maschinensprache.

Hier ist, was ein Roboter „sieht", wenn er Ihre Produktseite besucht:

{

"@type": "Product",

"name": "AI Analytics Pro",

"description": "Echtzeit-Monitoring von Markenerwähnungen über ChatGPT, Gemini und Claude",

"offers": {

"price": "299",

"priceCurrency": "EUR"

}

}

Ohne diese strukturierten Daten muss der Roboter raten, worum es auf Ihrer Seite geht, indem er Ihr HTML parst. Und wissen Sie was? Roboter sind schlecht im Raten. Sie sind auch ungeduldig — wenn Ihre Seite länger als 3 Sekunden zum Laden braucht, warten sie möglicherweise nicht.

Die drei kritischen Bereiche der Roboter-Optimierung

1. Crawl-Effizienz

Ihre robots.txt-Datei ist Ihr Türsteher. Sie sagt Robotern, welche Räume sie betreten dürfen und welche tabu sind. 2026 müssen Sie sorgfältig darüber nachdenken, welche KI-Bots Sie einlassen:

| Bot-Name | Eigentümer | Zweck | Sollten Sie erlauben? |

|---|---|---|---|

| GPTBot | OpenAI | Trainingsdaten | Ja, für Markenseiten |

| ChatGPT-User | OpenAI | Live-Browsing | Definitiv ja |

| Google-Extended | Gemini-Training | Ja für Sichtbarkeit | |

| ClaudeBot | Anthropic | Claude-Training | Ja für Sichtbarkeit |

| CCBot | Common Crawl | Datensatz-Aufbau | Hängt von Ihren IP-Bedenken ab |

2. Seitenarchitektur

Roboter denken in Links. Wenn Ihre wichtigsten Seiten 6 Klicks tief vergraben sind, weisen Roboter ihnen geringere Bedeutung zu. Die Faustregel: Jede wichtige Seite sollte in 3 Klicks oder weniger von Ihrer Startseite aus erreichbar sein.

3. Tiefe der strukturierten Daten

Fügen Sie nicht nur Basis-Schema hinzu. Schichten Sie es. Verschachteln Sie es. Verknüpfen Sie es. Ihr Organization-Schema sollte sich mit Ihrem Product-Schema verlinken, das sich mit Ihrem Review-Schema verlinkt. Das erzeugt einen reichhaltigen Entitätsgraphen, den sowohl Roboter als auch Agenten traversieren können.

Das Internet der Agenten: Die neuen Mittelsmänner

Hier wird es interessant — und hier versagen die meisten Unternehmen spektakulär.

Autonome KI-Agenten (wie ChatGPT, Perplexity und Gemini) indexieren Ihren Content nicht nur wie traditionelle Roboter. Sie verstehen ihn, synthetisieren ihn und empfehlen ihn Menschen. Sie sind die neuen Mittelsmänner zwischen Ihrer Website und Ihren Kunden.

Wenn ein Nutzer Perplexity fragt: „Was ist das beste CRM für ein 50-köpfiges Remote-Team?", listet der Agent nicht nur 10 blaue Links auf. Er analysiert dutzende Quellen, bildet eine Meinung und gibt eine spezifische Empfehlung ab.

Wenn Sie nicht in dieser Empfehlung sind, könnten Sie genauso gut nicht existieren.

Was Agenten wirklich wollen

Agenten versuchen, Fragen genau zu beantworten und dabei das Halluzinationsrisiko zu minimieren. Sie bevorzugen Quellen, die bieten:

| Agenten-Präferenz | Warum es zählt | Wie optimieren |

|---|---|---|

| Semantische Klarheit | Reduziert Fehlinterpretation | Klare, jargonfreie Sprache |

| Überprüfbare Fakten | Reduziert Halluzinationsrisiko | Quellen zitieren, Daten einschließen |

| Transaktionsfähigkeit | Ermöglicht Handeln | APIs, Buchungs-Widgets, klare Preise |

| Hoher Konsens | Baut Vertrauen auf | Drittpartei-Validierung, Bewertungen |

Der Sichtbarkeits-Score: Ihre neue Nordstar-Metrik

Im traditionellen SEO trackten Sie Rankings. In der Agenten-Optimierung tracken Sie Ihren Sichtbarkeits-Score — den Prozentsatz relevanter Prompts, in denen Ihre Marke in der KI-Antwort erscheint.

Hier ein Framework zum Nachdenken darüber:

- 0-10% Sichtbarkeit: Sie sind unsichtbar. Dringendes Handeln nötig.

- 10-30% Sichtbarkeit: Sie existieren, aber genießen kein Vertrauen. Entity-Stärke aufbauen.

- 30-50% Sichtbarkeit: Sie sind wettbewerbsfähig. Auf Differenzierung fokussieren.

- 50%+ Sichtbarkeit: Sie dominieren. Pflegen und verteidigen.

Die meisten Marken sind schockiert zu entdecken, dass sie in der 0-10%-Kategorie liegen, selbst wenn sie #1 auf Google für ihre Hauptkeywords ranken. Das ist das Paradox der drei Internets: Traditioneller SEO-Erfolg übersetzt sich nicht automatisch in Agenten-Sichtbarkeit.

Das menschliche Internet: Wo Emotion noch gewinnt

Verwechseln Sie unseren Fokus auf Maschinen nicht mit der Abwertung von Menschen. Ganz im Gegenteil — indem Sie für Roboter und Agenten optimieren, bauen Sie im Wesentlichen eine VIP-Überholspur, die perfekt qualifizierte Interessenten zu Ihrem menschlichen Erlebnis liefert.

Was Menschen wollen, das Maschinen nicht liefern können

Ironischerweise werden, da KI mehr Content generiert, genuine menschliche Signale wertvoller:

- Authentische Geschichten: „Wie wir das gebaut haben"-Narrative, die KI nicht fabrizieren kann

- Originalforschung: Daten und Erkenntnisse, die nirgendwo sonst existieren

- Community: Foren, Kommentare, nutzergenerierter Content

- Persönlichkeit: Eine Stimme, die distinktiv Ihre ist

Die Marken, die das menschliche Internet 2026 gewinnen, sind die, die verdoppeln, was sie unersetzlich macht. KI kann die Features Ihres Wettbewerbers zusammenfassen, aber sie kann nicht die Gründungsgeschichte Ihres Gründers oder die Leidenschaft Ihrer Community replizieren.

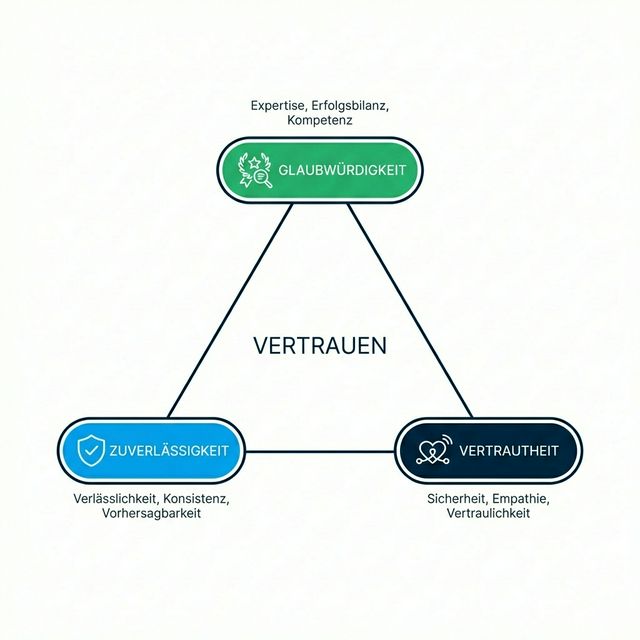

Das Vertrauensdreieck

Menschliche Konversion hängt von drei Faktoren ab, die ein Dreieck bilden:

- Glaubwürdigkeit: Wissen Sie, wovon Sie sprechen? (Expertise-Signale)

- Zuverlässigkeit: Halten Sie Ihre Versprechen? (Social Proof, Bewertungen)

- Nähe: Verstehen Sie mich? (Personalisierung, Empathie)

KI-Agenten können Ihre Glaubwürdigkeit durch Faktenprüfung verifizieren. Sie können Zuverlässigkeit durch Bewertungsaggregation bewerten. Aber Nähe? Da herrscht menschlich gestaltete Erfahrung noch unangefochten.

Warum Machine-First-Design Menschen tatsächlich hilft

Hier ist die kontraintuitive Erkenntnis, die alles verändert: Für Maschinen zu optimieren macht Ihr menschliches Erlebnis besser, nicht schlechter.

Denken Sie darüber nach:

- Strukturierte Daten zwingen Sie, klar darüber zu sein, was Sie anbieten

- Schnelle Seitengeschwindigkeiten verbessern die menschliche Geduld und Konversion

- Logische Seitenarchitektur hilft auch Menschen bei der Navigation

- Semantische Klarheit macht Ihren Content lesbarer

Das Unternehmen, das bei Maschinenoptimierung excelliert, bietet oft ein überlegenes menschliches Erlebnis als Nebenprodukt. Es ist kein Kompromiss — es ist ein Multiplikator.

Die Drei-Internets-Optimierungsmatrix

Hier ist eine praktische Matrix zur Auditierung Ihres aktuellen Stands:

| Optimierungsbereich | Roboter-Internet | Agenten-Internet | Menschliches Internet |

|---|---|---|---|

| Geschwindigkeit | Core Web Vitals | API-Antwortzeit | Seitenladeempfindung |

| Struktur | Schema-Markup | RAG-freundliche Chunks | Klare Navigation |

| Content | Maschinenlesbar | Zitierbare Fakten | Emotionales Storytelling |

| Vertrauen | SSL, Verfügbarkeit | Entity-Verifikation | Bewertungen, Testimonials |

| Aktion | Crawl-Pfade | Transaktionale APIs | CTAs, Formulare |

Bewerten Sie sich 1-5 in jedem Feld. Jedes Feld unter 3 ist ein Prioritäts-Fix.

Praxisbeispiel: Wie ein SaaS-Unternehmen seine KI-Sichtbarkeit verdreifachte

Lassen Sie mich Ihnen von einem B2B-Softwareunternehmen erzählen (Name aus Vertraulichkeitsgründen geschwärzt), das mit einem frustrierenden Problem zu uns kam. Sie rankten #1 auf Google für „Projektmanagement-Software Alternativen", waren aber in ChatGPT unsichtbar.

Die Diagnose:

- Ihre robots.txt blockierte GPTBot (versehentlich durch ein früheres „Sicherheits"-Update)

- Ihre Preise waren hinter einem „Vertrieb kontaktieren"-Formular versteckt (Agenten hassen das)

- Ihr Schema-Markup war minimal — nur Organization, kein Product oder FAQ

- Ihr Content war aufgeblähtes Marketingsprech, keine faktendichte Vergleichsdaten

Die Verschreibung:

- robots.txt korrigiert, um KI-Crawler zu erlauben

- Klare Preisseiten mit

Offer-Schema veröffentlicht - Detaillierte Vergleichstabellen mit strukturiertem Markup erstellt

- FAQ-Sektionen mit FAQ-Schema hinzugefügt

- Auf G2, Capterra und großen Software-Verzeichnissen gelistet

Die Ergebnisse (90 Tage später):

- KI-Sichtbarkeits-Score: 4% → 47%

- Markensuchvolumen stieg um 35% (Leute erfuhren durch KI von ihnen)

- Demo-Anfragen von KI-verwiesenem Traffic: 3,2× höhere Abschlussrate

Die Magie lag nicht in einer einzelnen Taktik. Es war systematische Optimierung über alle drei Internets.

Ihr 30-Tage-Aktionsplan

Bereit, für alle drei Internets zu optimieren? Hier ist Ihr Fahrplan:

Woche 1: Roboter-Fundament

- [ ] robots.txt auf KI-Bot-Berechtigungen auditieren

- [ ] Core Web Vitals testen (Ziel: alles grün)

- [ ] Organization- und Product-Schema implementieren

- [ ] XML-Sitemap erstellen oder aktualisieren

Woche 2: Agenten-Optimierung

- [ ] Ihre Top-10 „Geld-Prompts" identifizieren (was sollten Nutzer fragen, um Sie zu finden?)

- [ ] FAQ-Seiten erstellen, die diese Prompts zielen

- [ ] Vergleichstabellen mit strukturierten Daten hinzufügen

- [ ] Preise öffentlich veröffentlichen (keine „Vertrieb kontaktieren"-Blackboxen)

Woche 3: Menschlicher Feinschliff

- [ ] Gründungsgeschichte schreiben oder aktualisieren

- [ ] Kundenstimmen sammeln und anzeigen

- [ ] Fallstudien mit spezifischen Metriken erstellen

- [ ] Klare Handlungsaufforderungen für jede Seite gestalten

Woche 4: Messung & Iteration

- [ ] KI-Sichtbarkeits-Monitoring einrichten (Tools wie AICarma)

- [ ] Baseline-Metriken über alle drei Schichten etablieren

- [ ] Ihre am niedrigsten bewerteten Bereiche identifizieren

- [ ] Verbesserungen für Monat 2 priorisieren

FAQ

Kann ich das Internet der Agenten ignorieren und mich auf traditionelles SEO konzentrieren?

Können Sie, aber Sie werden einen wachsenden Prozentsatz der Entdeckung ignorieren. Gartner prognostiziert, dass bis 2027 50% aller Produktrecherchen mit einem KI-Assistenten beginnen werden, statt mit einer Suchmaschine. Agenten zu ignorieren bedeutet, die Hälfte des Marktes Wettbewerbern zu überlassen, die es ernst nehmen.

Wie prüfe ich meine Sichtbarkeit im Internet der Agenten?

Sie können Plattformen wie AICarma nutzen, um die Präsenz Ihrer Marke in KI-Antworten zu tracken. Traditionelle Rank-Tracker sind für diese Schicht völlig blind — sie messen nur, was sie schon immer gemessen haben (Google-Rankings), und verpassen die neuen Entdeckungskanäle komplett.

Sind strukturierte Daten wirklich so wichtig?

Ja. Strukturierte Daten sind der einzige Weg, eindeutig mit LLMs zu kommunizieren. Ohne sie verlassen Sie sich darauf, dass KI probabilistisch „rät", was Ihr Content bedeutet. Manchmal rät sie richtig. Oft nicht. Mit Schema-Markup geben Sie der Maschine explizite Anweisungen, statt auf das Beste zu hoffen.

Was ist der ROI der Optimierung für alle drei Internets?

Basierend auf unserer Analyse sehen Unternehmen, die systematisch für alle drei Internets optimieren:

- 2-4× Verbesserung der KI-Sichtbarkeits-Scores

- 25-40% Reduktion des unsichtbare-Marke-Syndroms

- 15-30% Anstieg qualifizierter Besucher (höhere Kaufabsicht)

- Bessere Konversionsraten (weil Besucher durch KI-Empfehlungen vorqualifiziert sind)

Wo sollte ich anfangen, wenn ich überfordert bin?

Beginnen Sie mit der robots.txt. Es dauert 5 Minuten, sie zu prüfen und zu aktualisieren. Dann gehen Sie zu Basic-Schema-Markup über. Diese beiden Fixes allein können den Needle signifikant bewegen, und sie sind das Fundament, auf dem alles andere aufbaut.